画像の作り置きがなさすぎるの…どうしましょう…

人がいたのね

安心しましたわ

ほっしゅ

ほしゅ

ほほほほ

謎のいきもの

ほっしゅ

サンイチ

ほしゅ

マジナイに広告入るようになったのね

いいことだわ

ほっしゅ

20!

保守ありがとうございました

今から絵師のLora学習して寝ようと思うんだけど

GUIの方の数値教えてクレメンス

一応画像は100枚用意してきた

サンイチ

アナルビーズ作り終わったから次ので遊ぶでー

とりあえず1回目の作成でワイキャラがどう出るかとか確認してないけどまずは良さげやな!

やっぱ作ったLoRAを初出力する時のドキドキはたまんねぇぜ iPhone だとマジナイに広告出なくておかしいなって思ってたら広告ブロックアプリ入れてたわ

いつから広告入れてたんだろう

今日からマジナイ使うたびに広告ポチるわ

サンイチ

サンイチ

レコーディング風景作りたいんやが

手で持つタイプやなくてコンデンサーマイクを出したいんやけど出ないんや

ええプロンプトないやろか サンガツ

sd-scriptsの解説ページを作ってくれた神のおかげで

浦島ワイも新しいツールを試せそうや

ありがたやありがたや

キャラの顔塗りつぶして衣装だけ覚えさせようとしたらのっぺら坊しか吐かないLoraになってワロタ

ぼざろedLoraすき

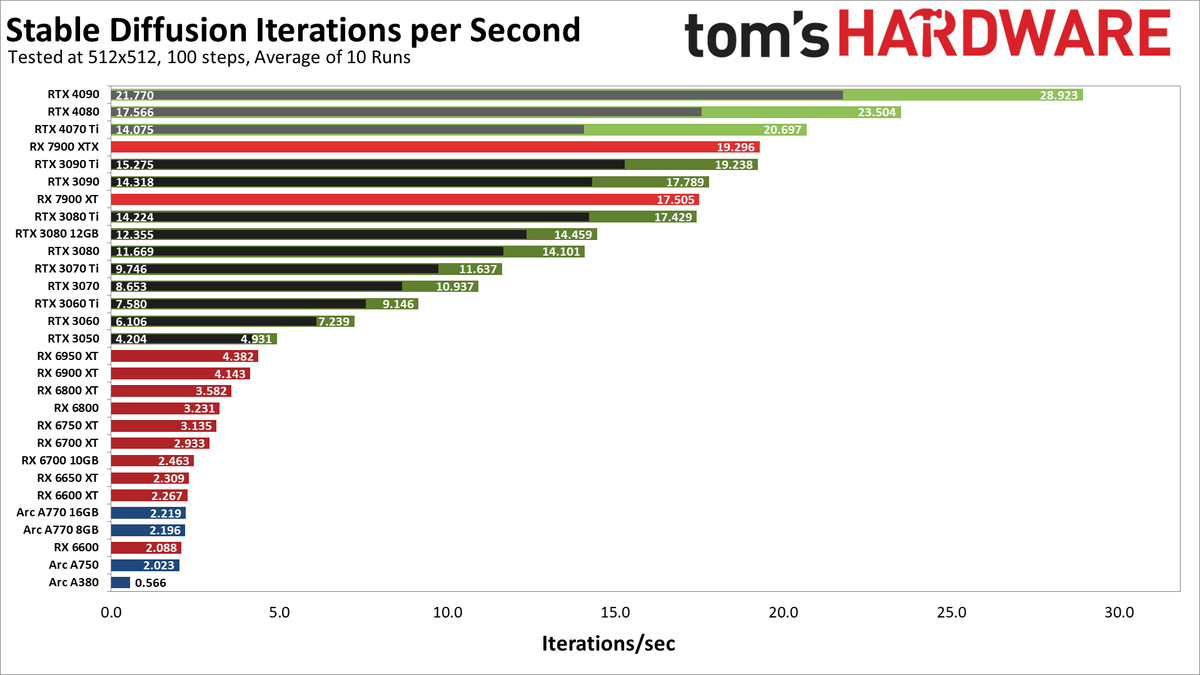

3080Ti12GB

サイズ512バッチ5でVRAM11.6GB使用

こうなるとモニタオンボ接続も視野に入るな

普通のメモリはシステム全体で15.5GB使用こっちは32GB必須やな

VRAM温度は低電圧化済み+ファン全開で64℃まで下がった

デフォルトで使ったら死ぬわな

サイドパネル開けてサーキュレーター当てた方がファンの磨耗抑えられるしええな

なんかかわいいの出来たから貼りたい

サンイチ!

昨日上がった7thでDB回そうとするとエラーでるんだがおま環?

RuntimeError: Error(s) in loading state_dict for UNet2DConditionModel:

Missing key(s) in state_dict: "up_blocks.0.upsamplers.0.conv.weight", "up_blocks.0.upsamplers.0.conv.bias", "up_blocks.1.upsamplers.0.conv.weight", "up_blocks.1.upsamplers.0.conv.bias", "up_blocks.2.upsamplers.0.conv.weight", "up_blocks.2.upsamplers.0.conv.bias".

Unexpected key(s) in state_dict: "up_blocks.0.attentions.2.conv.bias", "up_blocks.0.attentions.2.conv.weight".

エラーはこれ、safetensor経由のマージだとなるぽいけど治し方がわからん…

danbooruではhead out of frameというタグが顔除外されてる絵に使われてるからそれで勘弁してもらうとかなんとか

{{{サンイチ}}}

どの段階のモデルが正解なのか頭が理解しなくなった

終わりやね

サンイチ!朝はたっぷり乳酸菌飲料!

torchアプデしたらxformers動かなくなった

体感速度あんま変わらんからいいか

さんがつやで

>>29

首から上全部背景と同じ色で塗りつぶしたとか、体だけ残して頭と背景全部透過させてた? それとも、頭の中の目や鼻や口と言ったパーツを肌色で塗りつぶしたんか? サンイチ!

顔だけの画像+顔だけloraでi2i雑コラして作ったエロ画像5枚足して再度Lora作ってみた

雑コラ追加前の顔のみlora(なかなか股開いてくれない全年齢仕様)

雑コラで妥協した髪形やら全体のバランスやらが、ダイレクトに悪影響及ぼしてるのがキツい

2次創作と考えたら許容内か……

あとやたら口開いて、色味も変わりすぎぃ……

やっぱ雑コラスキルは重要なんだな、と思った >>48

ガビガビになってないし顔の造形も絵柄もかなりええ感じに見えるんやけど、俺がキャラ知らんからなのかいな? >>48

closed mouth入れても開けっ放しなんか?

あとはopen mouth入ってたりせんか? 汎化性評価するためのテンプレみたいの欲しいな

表情、服装、アングルいちいち考えて入力するのだるいんや

ブルアカの新キャラ?のAI絵渋に溢れてて草

LoRA配布されてると増え方がダンチやな

pixivとfanboxにだけがんばって投稿してるマンなんだが

ちちぷいみたいなAI系サイトにも投稿してる人って多いの?

書いててステマみたいな質問だと自分でも思ったが

ステマではなく投稿しにいく価値があるのかどうか意見を聞いてみたい

学習データ開示してるLoRAやないと個人利用用途以外で使うの怖いわ

LORAってウイルス仕込めるんかな

ckptは仕込めるって聞いたけど

夏コミくらいからAIイラストで作った同人誌とかも激増したりするんかね

コミケはAI禁止とかにするんかいな?

>>57

safetensorsは読み込む時に完全にデータ扱いで処理されるから

Pytorchのあるかどうかも分からん脆弱性とかを狙わん限り無理や

対してckptは巨大なデータをPythonスクリプトで包んだような構造しとるから

このスクリプト部分に何か仕込めば好き勝手できてまう

ただ、AUTOMATIC1111だとckptに変な物が仕込んであったら読み込まない処理が随分前に入っとるから、そこまで恐れることもない 版権二次創作禁止しとるコミティアならやれそうやけどコミケは無理やろ

>>54

ツイッターの権限要求が異常

商売っ気もありすぎ >>56

imgurに1枚だけ上げるのを5回くり返したときは画像そのもののURLを載せてくれると助かるで

それか一度に5枚上げて1つのページにまとめ、そのURLを載せる方法もあるけど画像の直URLがあったほうがありがたい このキャラの綺麗な画像検索エンジンで漁っても見つからんかったから教科書買ったわ 自炊して学習データにしてみるやでー

エレン先生みたいのならblonde,sidetailで素出しできそうな気もするけども

エロゲ塗りloraニキサンガツ

マイナー作品路線好き

世の中を楽しくする良いAIや

エレン先生なら作者本人のツイッターでよくないかと思ったらデフォルメしかねぇ

>>62

サンガツ

なんかうまい貼型がわからんかったんや。

コピーURLさえすれば何とかなるもんと思ってね。 >>49

髪型が一番怪しさ抜群になってる

長髪は難しいな

反面、短髪キャラはかなり楽だと思う

>>51

closedでもガンガンに口開ける

多分エロ素材が口開いてるのに引っ張られてるっぽい 木馬Lora

こういう顔が吹き飛ぶのは正則化入れたせいなのかな

やっと過学習から逃げられた気がする

しかしネガプロに(Blurry:1.4),(depth of field:1.2)ここまでやらんと脚すらぼやけるなんでやねん sidetail、結び目の位置が高くならん?

エレン先生みたいな髪はなんて入れれば出るんじゃろ

>>74

これでめっちゃ動きのあるアクションシーン描いてほしい ずっとLoRAは正常に吐かれるのに全く絵柄に反映されないと思ってたら

sd-scriptは0.4.0相当だけどWebUIは更新してなかったせいだったわ

WebUIだけ見てると反映されてないだけで生成自体はちゃんとされてるように見えるけど

コマンドラインはめっちゃエラー吐いてて草

>>75

簡単に言えば1枚物(顔だけでも)ならただのコピー機にもできる技術なので使い方次第だわな

ツイカスがよくやってるように、乱用すればAI画像はコピーだっていう悪い評判が広まるし

包丁と同じ道具で使う人によっては人を幸せにもできるし殺すこともできるともいえる

いずれ来る法規制時にどっちの評判が広まっているかって事でもある サンイチ!

トリプルジョブかな?

やっぱ男が出ねーな

背景に消されちまってる

なんとかなんねーかなあ

黄昏よりも昏きもの…

元画像の絵柄が安定してないけどretrostyleや1990sもよく効くので面白いかな

ヤケクソ感が楽しい

すまん最近AIにハマってキャラ学習勉強始めたものなんだが、LoraってのはTI,HN,DBで作成した元のモデルデータとの、差分ファイルのことでしょうか?

また今はHNでキャラ学習させてますが、TIやDBのが優れてるのでしょうか。色々弄ってますがHNと比べて上手く出力出来なくて勉強不足を痛感します…

初歩の初歩ですみません

>>80

寝ぼけて修正忘れたので貼り直して寝る

majinaiのNSFW見れへんのやがワイだけか?

NSFW選んでsearch押すとなぜかall agesに戻される

サンイチ

>>85

ワイもそれなってキャッシュ消したら直ってたがこちらの環境での話なので責任は持てん >>74

そのまんますぎて怖いわ

むしろ公式よりうまい

所要時間10分

素材たった15枚pixivですら総登録13枚

ほんまやべえなLora >>87

キャッシュ消したら見れたわサンガツ

ただall agesとNSFWで一度searchした後にall agesをオフにしても

またall agesとNSFWに戻されるな

そういう仕様なんやなって >>83

DBの効果を別ファイルにするような学習手法

VRAM8GBで学習可能、時間は短い、ファイルサイズはDBより小さくて他のモデルでも使えなくもないので流行ってる

loraでググると無線関連もコンタミするから大変だ いや絵の素材無さすぎてコスプレ拝借したけどアカンわ

7th通してやっと絵になるわ7thの偉大さを知ったわ

>>82

なつい。原作絵も巻によって結構変わるよねw おしゃぶり

Loraの次は動画系が流行りそうな気がする

Tune-A-VideoとかInstruct pix2pixを使っての動画編集は実用レベルまで来とるわ

Colabでsd-script使おうとして

!pip install --upgrade -r requirements.txtやったらエラーになったわ

画像のタグつけに使うプログラムぽいから消して動かしたけど

>>92

ありがとうございます!

今はエポック数で悩んでますが色々試行錯誤してみます

早く皆さんみたいになりたい… スレイヤーズ2枚目は、素材画像にもそんな構図と顔ないのに出てきたのでちょっと驚いた

もうずっと原作追いかけてなくて気になってきたけど思い出のままがええか…

Instruct pix2pixはあんま語られてないけど実用性低いんか?

とりあえず今モデル落としてる

>>91

チェックつけた後即search押してない?

枠外クリックするだけで自動的にsearchしてくれるで >>103

モデルマージしてやってみたけどあまり上手くいかんかったは

上手いことできたら教えてや! >>103

メモリ足りなかったのとうまく使えなくて放置 半リアルくらいのの絵柄が好きなのに解像度上げると勝手にアニメになりやがるチクショウ

Negativeにanime入れてもいまいちだしなんか良い呪文ないものか

>>103

現状は、学習にしては環境の敷居低めで学習時間もそんなにかからなくて、目に見える結果が直ぐ出るLoraが存在感強いせいで、pix2pixはまだ触ってすらいない人も結構居そう……っていうか自分もまだ触ってない 出回ってる短時間LoRAは細かい修正効かないのが難点

短いepochで過学習気味だから最終的には自分で作る羽目になる

>>72

遂三角木馬つくったのか

その顔の崩れ方rora強さ1にキャプション全部ぶち込んだ時になったことあるわ loraの学習、どれぐらいが妥当なのか、今使ってるのが過学習なのかすら分からなさすぎて雰囲気

むしろマイナー作品やキャラは公式も二次創作も少ないからこそAIに頼る人らが続出しとるんや

NAIで名前入れても、髪型の雰囲気は似てないこともない

程度しか出なかったけど

Loraのおかげで本人が出るようになりました

作品はメジャーだけどキャラが多いと他キャラの要素が混じりがちだから学習頼りになるよな

>>116

1girl, spread legs, pussy で脱がなかったら過学習、くらい適当でええんやないか アルトリアペンドラゴンが多すぎるせいで普通にやっても目当てのが出せないから学習のおかげで助かった

8割口開けてる画像で学習させたから

close mouthですら弾き返して困る

まあ口だけi2iで直してるけど

>>122

48GBってのは誤報やったんか?なら4090でも十分ええかもな >>121

なるほど

「プロンプトの指定を異様に弾いたら過学習」

ぐらいで考えたら良いか 5090来るまでは24GBで打ち止めか

業務用のやつやないとこれ以上くれないかもしれへんな

過学習一歩手前が美味しいみかんやから困る

何が正しいのか読み込んでる内に崩壊する

過学習一歩手前で一端止めて

そのチェックポイントから学習率を一桁二桁下げるとか学習画像絞ったり増やしたりして再開して仕上げるというテクはある

LORAでどれだけ役立つんかは知らん

まあ、あのケチ企業が突然流行りだしたAIへの需要に対応してVRAM増やしてくれるなんてあり得ないだろとは思ってた

1girl, spread legs, pussy だけですぐ脱ぐモデル、お股ユルユルなのかな?とか思ってしもうた

イラストの案件やってるんやがAI見慣れすぎてて自分の下手さ忘れてたわ

デザインとか構図がふわっと決まってて被写体二人だからAI使ってもあんま意味なくてワイの素の実力がもろに出てギャップに泣いてる

>>125

Tiじゃなくてtitanの方になるんとちゃう 消費電力: ~600Wって

4090tiは常時電子レンジ使うようなもんか

微調整して絵にしてpussyとsquattingとarms upとnsfw

素材タグ付けの時点で1girlついてるから女の子と認識してんだなえっちや

以前似たようなレス見たけど頭が異物のキャラにlatentでハイレゾ掛けると人の顔が生えてくるわ 今言われてるのはこれ

4090tiならまだしもtitanって絶対パンピー買えないやつや

>>138

これ見て確信した

革ジャンのクソは二度とロープライスにメモリ積むことは無いと 学習中はCPUそのものは大して働かないし実消費電力は構成の最大電力の半分ぐらいに落ち着くと思う

コラボで他人の作ったローラを借りて遊んでた民なんだが、今までは問題なく行けてたのに今日試したらエラーをはいて動かんくなってしまった。

これ解決の仕方わかる人誰かおらへんか…助けてクレメンス… kohya LoRAで1e-4で5エポック廻した後で更に追加で5e-5で5エポック廻す、とか出来る?

inpaint sketchでおペニスに繋がるよう男の身体を描いたらあっさり出るやん

驚きや

>>40

KTMや

わいもバイク旅させようかな

>>143

LoRAの拡張(additional network)が死んでる気がする。消して入れ直すか、WEBUI最新にしてWEBUIの機能でLoRA使うかすればいいかもしれない アニメ絵ならともかく三次のLoraは元のやつと少しでも混ざると

雰囲気似てるただの別人そっくりさんになって終わるから

うまいやり方をしりたいねぇ

loraのデータベースが将来構築されて、promptに入力されたタグに従って適切なloraを適用するみたいなんができるんやろか

多分一つのでかいモデルを構築するよりもずっと効果的だよな

>>143

automatic1111で使えばLoRA使えるでxformers止めればそこは通過できる

解決策はワイも模索中や 学習なにそれくいもんすか?

ワイはマイペースでt2i

ハイレゾかなり安定してきた

ようやく色んな路線に取り掛かれそうだけどちょっと呪文を弄るとこうなるから難しい

ハイレゾにすると再描画するから実際に描き直しとかそういうワードを入れると有効になってるイメージ

たた゜の勘違いかも知れないけど 使用目的が違いすぎるから効果的とかクソもない

森と女の子描いて!

が普通のAIで

Lora主体だと

富士の樹海と松永先生描いて!

とかやらんと行けない

かと言って可愛い女の子Loraなんて作るのは本末転倒

配布スズカ+自前ガッフェ

こんなん仕事行けなくなる >>142

LoRA学習の待ち時間は思う存分RTAするんだぞ Instruct pix2pixの件サンガツ

よく見たら138スレで出たばっかの技術やったわ

これからって感じかねえ

再現したいキャラが多すぎる

>>151

前より良くなったやん!

って思ったが相変わらず手がクリーチャーのままやなwww頼むからそこも気にしてくれ Basil Mixで描かせるとほんと写真みたいになるやね

LoRAやっと環境作れたぜ…罠が多すぎる

h

ちな上手くいく前のノベタちゃん

>>158

basilうんぬんではなく元々のSDの学習結果やろ

てか公式がそもそもが実写モデルだったことすら今は知らない人が多そうやな >>150

ちゃうんや、昨日の時点では普通に導入もできてたしうまく動いてたんやそれが今日朝から一切うまく動かへん >>157

現時点では手指に関しては何一つ指定して無いからなあ

ハイレゾというかローカルに手を出してるにしてはネガがペラッペラやし

今はまず何よりもまともに見れるハイレゾを安定させる塩梅を模索中なんでもうちょっとかかる

金ピカゴージャスにしようとするとどうしても呪文が膨れ上がるのでNAIちゃん以外のモデルが使えんのが辛いところ

思いっきり圧縮したらごっそり装飾性が失われるしそもそもNAI以外のモデルはデカい装飾品を作るのが苦手なのかって感じるし >>153

ちゃんと消しとけよ

馬主とかサイゲを敵に回すとか社会的に消されるわ

pixivでも調子乗ってエロウマ並べてるヤツ居るからいつかまとめてやられるぞ WebUIかsd-scriptのVersion上がったらまーた動かなくなりそうだから

今の環境Dockerイメージで固めておきたいわもう

AUTOMATIC1111 がなんか追加でダウンロードしてた

またなんか増えたのかな

Downloading (…)olve/main/vocab.json: 100%|███| 961k/961k [00:00<00:00, 13.8MB/s]

Downloading (…)olve/main/merges.txt: 100%|███| 525k/525k [00:00<00:00, 6.62MB/s]

Downloading (…)cial_tokens_map.json: 100%|██████| 389/389 [00:00<00:00, 163kB/s]

Downloading (…)okenizer_config.json: 100%|██████| 905/905 [00:00<00:00, 413kB/s]

Downloading (…)lve/main/config.json: 100%|██| 4.52k/4.52k [00:00<00:00, 798kB/s]

LoRA学習うまくいかんかったけどlora_train_popup.pyのself.use_8bit_adam: boolをFalseにして8bit adam無効にしたら学習できたで

ちなグラボは1070無印で画像を読み込んで学習スタート時にこのエラー出てた

Error no kernel image is available for execution on the device at line 167 in file D:\ai\tool\bitsandbytes\csrc\ops.cu

久々にマージ見たらなんか増えてるやん

これは便利そう

馬シコの馬鹿ゴロは警告後もファンボで利益上げてたからやで トーシローのここまで取り締まるほど暇やない

ハイこの話やめっ

今更クラウド環境構築しようとしてよくわからず詰んでたけどタイミング悪かっただけかよ

>>144

出来るよ

使ったことないけど--help見てみたらなんかLRのスケジューラみたいなオプションあった >>167

vocabってファイル名の感じからして自然言語処理周りっぽいね >>156

再現度高いな

塗りもloraで寄せてる?それともモデルとか由来? エロ動画は3Dとlive2Dが強すぎてAIじゃまだ無理や

・次元は多ければいいというものではない

・学習量を減らすのと効果を弱めるのは違う

ということがわかったわ >>176

これ見るとワイが作ったやつが崩れ気味なのは脳死で128にしてたせいくさいな >>176

同じ学習素材で試したわけじゃないからあれやけどdim256と128であまり変わらんなぁとは思っとった さっきローラ導入できなくなって質問してた初学者やが、何とかなったわ助言くれたニキサンクスやで

聖人や

>>176

すまん、値大き過ぎるとこんなに崩れるよって話か dim64でこんなグチャグチャになるって何したんやろ

見た感じ過激なLRか画像不足で過学習しとるだけに見えるんやけど

>>174

軽井沢もフリーレンも学習モデルはNAIで出力は両方AOM2だから

かなり選定する素材に寄る感じだね

アスカテストについて質問なんですが

wikiを見てると、最初の説明ではBatch count 10にしろと書いてあるんだけど

Batch Count 2、Batch Size 5

Batch Count 5、Batch Size 2

でやってる人がいたりするようです

10枚出力できる組み合わせの中で一番速いのを使えばいいということ?

あと

Eta: 0.67, Clip skip: 2

のところは多分設定できたんだけど Model hash: 925997e9 がどのモデルかわかりません。

>>186

画像は47枚でlearning_rateは1e-3やで

network_alphaを1にするときは1e-3がいいらしいからそうしたんやけど大きすぎたんかな dim128でもそんな崩れたりしないけどなあ

4chanのこの画像のほうが正確ちゃうか

>>183

秋田繋がりで👹→包丁ってことか

物騒なキャラやな… HNプロンプトで数値決めないといけないの面倒くせーな

複数入れて絵柄変えまくれるのは面白いが数値バーだけは残してほしかったわ

今出来上がったdim128の学習データ普通にいい感じだわ

とはいえ64とかで時間減らしつつしっかりしたのができるなら当然そうしたい

dim上げると学習に必要なepoch数も上がるんかな?

時間がかかるとはリドミに書いてたけど処理時間の事なのか必要epoch上がるんか知らへん

>>190

繰り返しは10にしとるんか?

47枚 x 繰り返し10 x 10epoch = 4700ステップは

dim64でalpha1の1e-3だと恐らくやり過ぎやで

alpha1で1e-3は速成のパラメータやし

しかもこれはdim128での場合やからdim64だと実質2倍の2e-3相当でやっとることになるし

もう一度試す気があるかは知らんけどdim64の4700ステップならalpha1の2e-4あたりが無難やと思う 上見たらcolabでLoRA使えんくなったニキおるな

ワイもなんや

せっかく作ったのにガッツリお試しできへん

>>197

複数出力するベンチマーク的な使い方がある 関係あるか分からんけど

dim256

アルファ1

学習率1e-3

解像度1024

で回したやつを重み1で使うとグチャグチャになった学習元画像が出力されるな

0.5なら普通に使えるから気にしてなかったが

>>201

自分も驚いた

プロンプトにmonochromeとかgreyscaleを自分で入れない限りほぼカラーで出るよ 話題になってた4chのtorrentってどこにある? さがしてもみつからなかったから教えてほしい

>>205

はえ~!レア作品の二次が捗りそう

>>206

もう消えたよlainも消えた

色々早すぎるわ LoRAやと背景切り抜きしなくてもええっていうのはもう定説という感じかね

絵師Lora学習させて使ってみたけど健全な絵しか使ってなかったからエロがでなくなってしまった

上のガッフェはnet dim128だったけど今64で再走

同一seedでloRA外したら背景ガラッと変わるから影響あるんだろうけど気にしてない

git pullして止まると頭の中でホラー映画のシーンが過ぎる

>>189

naileakのfullのckptがそのモデル

もともとnaiの再現性確認でやってたテストをボードごとの性能差を測る指標にしただけで気にするほどのもんでもない

4090みたいにsizeを1にすると下位モデルと生成時間はさして変わらんけどsizeを大きくできるから時間あたりの生成枚数が多くなる、というケースもあるし

コマンドプロンプトに出るitを見るなら1枚出すだけでもいいよ >>209

画風学習で求めてるのって実際は目とかの顔の特徴だけやから顔だけ学習すればええんや

特殊な体型してる画風とかを学習したいならその手は通用せんけど

その場合は脱いでる画像多いやろから問題ないしな >>189

基本はバッチ10で他の人との比較に使う

バッチサイズ増やしてのパターンは、同じ10枚を出力する時に同時出力枚数が効率よく出せるかを見る為のもの

同データが増えたら比較対象になるけど、そうじゃないとあまり比較対象にはならない

別レギュレーションみたいなもんや >>199

>しかもこれはdim128での場合やからdim64だと実質2倍の2e-3相当でやっとることになるし

これマジ?そういうことなの? LoRAを複数モデルにマージする奴やってるんだけど

ベースモデルが違うものはもちろんだけど絵面が違うもの混ぜていくとHNの時みたいに似てるけどっていう微妙な感じになってしまうな

アニメ系LoRA全部まとめようっていう欲張りはダメか(笑)

>>216

絵柄loraとエロlora同時に使えばええやろ 次元増やしたら学習量も増やさんとあかんとかそう言う話は関係ないんやろか?

>>199

47枚で10は多いと思ったから繰り返しは5や

実はdim128でも学習してたんやけど

64も128も駄目だったんで多すぎるのが悪いんやと思って省略したんや

TIのdeep penetration missionaryもいいぞ

>>213 >>217

ありがとうございます

じゃあモデルは適当なのにして、バッチ10と5×2で両方記録とってみることにします 学習って興味無かったけど上の方のフリーレンの画像を見て意欲が湧いた

でも1070 8gbだとやっぱキツイっすか?

>>218

演算精度が局所的に落ちるところがあって

そこの原因の反映される値がデカいって問題を解決するためにできたのがパラメータAlpha

そこでの反映量がnetworkdim分のAlphaにされるから

Alphaをnetworkdimと同じにして無効化しない場合networkdimを変えると学習の反映量が変わるんや

ただnetworkdimに連動させとる訳やから何かしらの理屈があって多少は融通が効くんやろうけど

よく分からんし自分で試す限りは学習が効きすぎる感じがあるから128より下げる場合はLRも下げとる

最適値は知らん >>74

モノクロ画像がキャラの特徴掴むのに役立ってたりせえへんかな 人間のワイからすると色の特徴は覚えやすいけど造形を覚えるのは難易度高いイメージあるわ モノクロタグ付けたモノクロ画像あったら造形だけ学習しやすそうというか LoRA流行ってるけど未だにSTのお世話になってる

最終的にモデルを弄るとガチャ率が上がることに気づいた

前スレで体位loraがdim1でやってたとか言ってたな

TI学習での苦労はなんだったのだというくらいに、LoRA簡単に実写顔ひっぱれてすげぇなあ

ファイルサイズがでかいのが難点かなとおもったけど、dim4で4MBぐらいならまあ許容範囲かな?

>>227

多分数時間オーダーになるからキツいのは間違いない

やれるやれないで言ったらやれる

ただ1070はpaperspace無料以上Colab無料以下くらいの性能なのでColabでやったほういいかもしれない

Colab無料(2560, 16GB)

1070(1920, 8GB)

Paperspace無料(1536, 8GB) あー、でもColabって起動時間短いから時間かかりそうであるからこそ1070でやるほうが楽ってのはあるか

>>228

はぁ~~じゃあalpha=dim=64なら学習率の変更話でもいいけどalpha32にしたなら実質1/2ってことか 144MBドカ食い気絶部はもう嫌やから容量下げられるなら大歓迎や…

>>232

特定の誰かの顔を学習して生成してるのならすぐに消せ 全体意識:dim128

一部、パーツ系意識:128より低めの64とか32

程度の雰囲気で学習してた(根拠無し)

そろそろlora学習データの細かいまとめとか出だすに違いない、と他力本願

全然わからない

ワイは雰囲気でパラメータを決めている

288MBドカ食い気絶部はうっかりpaperspaceの永続ストレージオーバーして月跨ぎしちゃうリスクあるしcatboxの200MB制限にもギリギリ収まらないから自分も退部したい

Kohya-ss guiの初期値がdim8だから遠慮して12にしてたわ

128とかありなんかい

>>225

特別変わったことはしてない思うけど

どっちも用意した素材は反転含めて60枚くらい

学習モデル:NAI

dim32

learning_rate:0.0001

vae:final-pruned.vae.pt

step5000

>>227

1080(8GB)でwebuiのsd-scriptsで学習してるけどstep5000で4時間近くかかる

両方共かなり過学習気味だったからstepはもっと減らせると思うけど正直買い替えたい ニキらのレス見てると自分の設定の雰囲気加減に恥ずかしくなってきたわね

参考にしたサイトがdim128だったから脳死で128にしてたわ

それでいい感じに作れてたから尚更

全体構図なら下げればいいのかパーツなら下げればいいのか

どっちなんやろ難しいな

そろそろLORAで版権キャラを2キャラ以上並べられるようになった?

dimの影響も学習率の影響もどうせ雰囲気

論文読んでもわからん

いいシードでいいものできればおっけー

使ってるスクリプトがデフォ128だからずっとそうだわ

結果には満足している

実際いいものかどうかなんて自分の目で確かめるしかないし雰囲気でええんちゃう?

>>245

数か月後にはまた別の世界になってるさ…たぶん

伊達と酔狂で遊んでるわけでな(笑) dimは128にしないといまいちっぽい気がするが、素材次第かもなぁ

>>245

流行りだからしゃあない

何か革新的なものが出たらすぐ話題は変わるからね TIのサイズの小ささと発動の単純さにはまだ可能性を感じてる

12月は階層マージ

1月はLora

来月にはなにが起こるかな

>>232

ちょっと実写系興味沸いてきた、使ってるモデル教えてほしい 10スレぐらい浦島のワイ、未だLoRA導入できず

まだダイナミックプロンプトでいろんな体位出しとるレベルだわ

ちなみにLoRAで足コキとかも結構正確に出せるものなん?

やっぱdim増やしたらvram消費も増えるよな

12GBだとバッチサイズ下げな厳しいな

お前らそんなに学習回してて電気代大丈夫か?

まだ学習やってないワイでも今月やばくて泣いた

次元数(rank)が違うとLoRAのマージができないっていう"次元数"ってnetwork dimのことだと理解してるんだけど、学習者ごとに各々好きな値を設定して配布する形になると、マージ互換性のないLoRAがたくさん出回ることになりそうだなあ

>>251

>>252

元々はNovelAIだったし移り変わりに不満はないぜ

むしろノンストップで進化続けてて関心してるところや Ti普通に有用だと思う。LoRA2つ以上使うと破綻してくる

LoRA or DreamBooth:キャラのベースデザイン

構図や仕草:Ti

みたいな棲み分けはよさそう

hassanblendの作者が実在女優(48)のモデルを作成例(水着)やHosted interface付きで堂々と🤗に上げてて笑った

外人ニキはほんとストロングスタイルだな

>>264

ギャングやな

どうせならテイラースウィフトとかニジウでやってくれや 読み間違いしてるかもしれないけれど

kohya版的には 学習画像と正則画像の違いはlossの重みが違うだけっぽい?

学習画像はlossの重みが常に1.0、正則画像はprior_loss_weightが適用される

prior_loss_weightが1.0なら正則化画像のフォルダを学習画像のフォルダに並べて置いても同じになる...はず

クラスを少ない枚数の正則画像で追加学習するんだからそりゃ正則画像に引っ張られるわ

ワイは雰囲気で学習している

個人的にnetwork dimは128が安定やな

まあeasy_trainingスクのデフォ値をずっと使ってるだけなんやが

dynamic promptsで体位含めてガチャしてると体位LoRA使えんしそういう場合は今のところTIの方が便利やな

loraでキャラモデルやらスケルトンやら個別にいじれるようになってきていよいよMODいじくってる感覚になってきた

学習が簡単になったのはいいけどR18ウマとかディープフェイクを当たり前のように貼ってるやつはおいおいってなるわ

馬はまあ海外の学習詰め合わせにいつも入ってるし需要はあるんやろなぁって

個々人で気をつけるしかないで

>>255

SD1.5で学習してbasilに適用。

学習画像はTI作ったときのものをキャプションともどもそのまま流用。

一応、キャプションの1トークン目に呼び出し用のトークン入れて固定

画像は512px9枚で10周設定、タグはtaggerでつけて整理。透明正則化有り

epochは20(実質10)

LoRA_Easy_Training_Scripts使用

clipskipは予め1に書き換え

設定はほとんどデフォルト。dim4にしてalphaも同値

ちなみにdim1で作ってもまあまあ使える感じだった。検証的には満足。もう貼らないけど やっとクラウド環境構築できたわ

vae用のフォルダができたって記事見たからmodels/sdのなかのvaeついてるやつ消してみたら通ったわ

こんなもんのために何時間もかかるから環境構築は嫌なんだよ

>>271

トリガーを{}に入れてても全部反映されてしまうんか 1日で4回も抜いてもうた

ゲームを一通り遊んでからスクショ使ってお気にキャラのdb学習が強すぎる

>>278

プロンプトにLoRAの読み込みが入ってるとdynamic promptsのガチャをする前に適用してしまうみたいなんや

もしうまく使えてたら教えて欲しい >>187

NAIかぁ サンガツ

前にトモセの別のキャラ学習させようとしたけどあんまうまくいかなかったから参考にさせてもらうで 学習の速度って生成速度×バッチサイズ(こっちはvarmが重要)であってる?

3060と4070tiだとvarm同じ12gbだけど4070tiの方が学習速度はだいぶ早い?

思い入れのあるキャラでシコると出る精子の量が違うのは科学的にも証明されてた事実だからね

バッチサイズは必ずしも速くなるとは限らない

gpuのパワーが余ってれば増やす方が早くなるけど増やしすぎてそっちがオーバーヘッドになればむしろ遅くなる

限界までバッチ増やすと若干遅くなることが多い

ただ、複数をいっぺんにバッチ処理することで学習の正確さは増すとされている

その辺のプラマイを鑑みてバッチはメモリの限界まで高くされることが多い

>>247

まあ無理だよなあと思って試したけどやっぱり無理だったわ

中途半端に混ざる

服交換くらいはなんとなくできるけどうさんくさい

とりあえず生成速度が学習速度とイコールになるのは事実

結局生成結果を見て教師との違いを覚えるのが学習だから

loraのメタデエディタが出来たみたいだからこれからプロンプトとか載せてくれる人が増えるんかな

>>269

こんなんガチのやばい画像とか流出しても

それAI画像ですって言えるやん >>280

ワイも気になってたんやが、これはwebuiの修正案件なんではないかな? >>292

すごい!これええな

例のプールやマジックミラー号を作れってことか 顔学習の解像度の幅ってどれくらいの刻みが良いの?

位置よりそっちが大事みたいだからリサイズ保存を繰り返すことになりそうだが

情報ありがとう。流石に4090は流石に躊躇するし4070tiにすっかなー

>>292

ええな

背景学習させる発想無かったわ

フードコート、エスカレーター、和式トイレ、風俗店、表彰台、体育館の演台

あたり挑戦してみたい >>293

画像を用意して学習させればおそらくいけるはずや

>>292

ある意味で一番汎用性の高いloraかもしれん キャラ学習と自分の学習と自部屋の学習でセックス可!

つまり……精液風呂も風船風呂も再現可能ということっ!

スマン途中送信してしもた

こういうのも学習させとるんやが、こっちは人を描こうとするとサイズが合わんかったりするので調整中や

ここまでの試行錯誤で分かったのは

背景学習の場合、人が写った素材も用意しておいたほうが良いかもしれん

学習時に人とのサイズ対比を学んでくれとる気がする

キャラと体位と背景が揃えば俺達は更に高みに上れるはずや >>301

精液風呂LORAあったで

最新4chanリストにgokkunで紹介されててカップやジョッキなど容器に精液を満たすヤツだが風呂も容器扱いで適用される模様 >>292

これ面白いわ

キャラLoRAと組み合わせても大きな崩れは出ない感じやで

>>292

ええな…………

男子トイレの写真集めるか コイカツとかでは背景も大事な要素やったなそういやと

>>292

背景が顔に干渉して悪影響起きたり難しいわね

lora階層でIN457を低めにすると顔へのアタリが柔らかくなった気がするけど数試してないので気休めかも 精液風呂みたいなまだプロンプトでどうにかなる要素はプロンプトでやった方が破綻しにくくていいと思うやで

ノープロンプトノーエーアイや

>>295

今ぶっちゃけVRAM12GBで困らんと思う

loraで学習は足りてるし

クソデカ画像もWQHDに近いサイズが出せりゃじゅうぶんや

皆が苦労してる一番の問題は学習やhires生成の速度

そうなると3090tiより速くてワッパも最強でブン回してもアチアチにならない4070tiは現状の最適解や 背景の学習が強すぎてキャラまで影響を受けてしまう時は

あらかじめ人のシルエットを合成した背景を学習させたら上手くいかへんかな?

>>311

まさにそれで困ってまして

試作したいくつかの背景LoRAは適用すると人物の描画に悪影響が出る

先のカラオケLoRAはまだマシな方なんだけど

影響を抑えるノウハウや情報がまだ全く無いんですわ 初めてloraで学習させてみたら画像生成できなくなってまた1からWebUI入れなおしや

もうヤダ、、

モデルのコピーとか拡張機能入れなおしとかワイはまだスタートラインにも立てないんやなって悲しい

240GBのtorrentはzipやないから中身選別しながら落とせるから一見の価値あり

コナンの犯人LoRAの方が伝わりやすそう

今かまいたちの夜やったことある人少ないだろうなぁ

>>48 と同じ画像でdimだけ128→4に変えてLoRa生成したら、なんかいきなりエロフルスロットル状態になってワロタ

あと、ちゃんとプロンプトで口閉じるようになった

顔だけLoRaとかでエロ出ない場合はdim下げると良いかもしれん

・dim上げる→学習元データに忠実になる

・dim下げる→割と学習元データから応用しだす(同人2次創作感が強まる)

っていう気がするけど、よく分からないので雰囲気 装甲悪鬼村正のキャラセットあるわ

茶々丸作ってたニキおったな

3060の12GBだとBatch sizeの数どれぐらいが限界ですかね?

VRAMが少ない環境だとエラーが出やすくなるらしいので

Batch countで数調整のほうが無難かもしれないですが

参考までに80Ti12GBやけどデュアルモニタ接続で512バッチサイズ5が11.6GB

768やとバッチサイズ3でメモリ不足

メモリ足りなくても学習止まるだけやから試行錯誤しておk

>>329

ありがとうございます。PCエラーかシャットダウンかかるかなぁと思いましたが

現状設定でどこまで出せるかやってみます。 まだまだガチャ要素強いし構図もあんまバリエーション出せないがようやく着せ替え安定してきたわ

ハイライトも瞳孔もない目、厚い前髪に隠れて描写のない眉毛、地味な色のグラデ髪

地味な特徴なのにAIが苦手な要素てんこ盛りじゃねーか

>>292

すごいやん! これ学習元モデル何使ったん? paperspace民やがLoRA学習のエラーと1日戦ってた...

昨日の神サイトが更新してくれていたので共有しておきます🙏

633 今、天王星のwiki見てきたら軌道傾斜角(i) が0.774°だった (ワッチョイ 1786-2Ez+) 2023/01/30(月) 17:44:04.03 ID:NbvlqB5R0

paperspaceでkohyaでもwuiでもxformers使うのようやく安定してきたので共有しておく

https://rentry.co/paperspace_de_xformers 前スレID:NNs9tBpX0ニキありがとう先にギブアップしてすまん

教えてもらった記述でColabのHuggingログイン動いたは逆にrequirements.txtのインストールで躓くようになってしまった

一旦諦めてsd-script古いバージョンのColabで我慢しますわ

4chのloraのtorrentってどんなのが入ってたん?単純にgitgudのまとめ?

せっかくなので一般的な深層学習(deep learning)関連からの話題を一つ

過学習、というのは学習元のデータに寄り過ぎることで、学習中にlossというのがあると思うんだけど、通常学習をするデータセットは学習用と検証用に分けられて、学習用を使って学習した後に検証用のデータを使ってどれぐらい上手く学習できたかを確認するんだけど、その誤差の平均がlossになる

これだけ見るとlossが小さくなるほど良いように思うけど、それだとコピペがベストということになるので汎用性を考えると小さいほど良いとは言えない(コピペに近づくのが過学習、と思ってもらってOK)

正則化とかも関連するんだけど、正則化は学習対象と近いけど分離したいデータとして、学習対象から出来るだけ違いが大きくなるように学習が進む。例えば女性キャラクターを学習させる時、概念としては1girlに含まれるけどそのキャラ(とりあえずAとする)を別個に学習をさせたいわけだ。その場合、1girlであるAを学習させるけど1girlと同じだと困るので、1girlの画像を入れて、1girlからは遠くAからは近い、という概念を学習させることになる

lossの話に戻ると1girlからはlossが大きくAからはlossが(ちょうどいいくらいに)小さい結果を返すのが理想となるわけだ

この辺の深層学習の基本的な理屈から考えると、tagに関しては大抵taggerを使っているけれど、実は正則化用の内容の基本(上の例であれば1girl)とキャラクターを分けるのであれば、学習対象は1girl, A、正則化の内容は1girl、とするのがベストなのかもしれない。背景の場合は、background, karaoke roomとbackgroundとかで学習すれば1girlとかとの関連が少なくなって誤爆で混ざることが減る…ような?

あとdimは学習できる特徴の数、と思ってもらうとわかりやすい。一見dimが大きいほど良いように見えるけど、服装やざっくりした容姿とかを学んだ後余力があると絵のタッチや微妙な形状、服の皺の位置まで学んで、結果的に模写に近付いていく、といった感じ

学習画像が白黒でも良いのはこの辺が多分関連していそうで、画像関連のAIは輪郭とかも別個に学ぶような仕組みになっていることが多いんだけど、その際白黒の方が的確に学習が行なわれる、ってことじゃないかと

なんや、pip最新版にするとsd-scriptsのインストールで死ぬw

>>330

横からやが有り難くいただくで

背景学習は間違いなく流行る モデルになってまうけど7thニキのv3.1なかなかええね

特にAはv3より線が細く被写界深度の表現もけっこうしてくれて好きな感じや

>>307

これkohyaのWebUI拡張に取り込まれたな

キーワードとか残せるようになったのありがたい 論文読んでもわからん

解説見てもわからん

エロけりゃ正解

最高のオナニーを求めて今日も学習させる

>>338

えっちな服とか覚えさせたいものの数が決まってたらdimも決められるの?

水着といったら競泳水着だけ出てほしければdim1とか >>334

前提モデルはnai.ckpt指定で廻したよ

作例は7th_anime_3.1_B >>338

サンガツや

taggerでタグ設定したけどbackgroundは入れてなかったな

ちと試してみるわ Colab3時間ぐらい回したら上限達するんやが一日一回しか無理そうやな

>>338

ほぉ……

なんかまさに今dim弄ったパターンいくつも出して比べてると、そんな感じを垣間見てる 7th_anime_3.1 サンプルだけ見ると顔だけアニメ調でコラ感あるように見える

白黒画像だけでもいけるもんなんかな、今度試してみるか

>>338

キャラの細部再現には128必須ってことかドカ食い継続やね… やっぱりだめだー

この時点で訓練データも正則画像データも認識してるのに

始まったとたんに何がないといってるのかわからぬ……

>>348

なるほどな、サンガツ! ワイも試してみるわ >>346

その服装の持つ特徴の多さによる

シンプルにdim1、とはならないけどswimwearとタグ付けして学習用画像を競泳水着だけにして正則化を透明もしくは無しで、dimは少なめにするとswimwearの概念は完全に上書きされた状態になる可能性が高くなるはず >>347

技術ができたんならどうせいつかは取り入れるのがAutomatic1111ニキや

2週間以内には来るやろ >>347

TensorRTはその環境特化のモデルに変換するみたいなイメージあんな

今まで通りモデルはckptで配布して、各自でローカル環境で変換かけるみたいな使い道になりそうやな

早くエロい人WEBUIにプルリクを出してくれ >>355

都合よく細部の特徴を学んでくれればいいんだけど、絵柄とか優先的に学習して肝心の特徴を学習してくれないこともあるからそこは試しながら様子見かなあ、と >>338

こういう話題なかなか見る機会ないからほんまありがたいわ、参考にさせてもらうで >>356

ロックできない言ってるからファイル開いてるんじゃないか

怪しいの閉じて、最悪再起動で >>134

亀やが電子レンジの消費電力は表示の1.6~1.8倍なんやで >>356

Linuxなんか?だいぶファイル足りなさそうやけどcudaとか 深層学習の本面白いで

エロ画像作るために勉強しとる

>>359

既存の概念の上書きになってくると正則化画像はビキニとかスクール水着より透明とか無しの方が良いって考えになるのか難しいな

サンガツやで >>356

訓練データのフォルダ名にスペースが入ってるように見える(usuとfrogの間)のでこれが悪さをしてる可能性がありそう

loraの場合は_とかも別の意味になりそう(repeatの回数)なので-とかで区切りにすると良いかも ポップアップの方は学習成功したけど毎回入力少しめんどくさいからコマンドライン版やろうとしたら

run_command_line.dat起動後に

subprocess.CalledProcessError:

Command '['C:\\sd-scripts\\venv\\Scripts\\python.exe', 'lora_train_command_line.py']'

returned non-zero exit status 1.

って毎回返されるからインストールし直しやらlora_train_command_line.pyの保存方法等見直しやらしたけど結局治らんで禿げそう

大人しくポップアップ版使うしか無いか

majiみてると、最終出力は縦長でも、hires前は正方形でやってるのをよく見るが何か知見あってやってるものなんかな

>>371

コマンド入れればええやん

メモ帳に置いとくだけだぞ 同じくポップアップ版しか使ってないな

そういえば一度入れて動かして出来てるかよく分からなかったui版、また挑戦してみようかな……

ポップアップきつくない?

としあきbatが一番やりやすいわ

としあきのwikiにLoRA学習起動バッチ置いてるからそれコピペして使ってる

としあきbatとマージはありがたく使わせてもらっとるわ

けどkeep_tokensのとこの表記

トークン長じゃなくて,区切りで判断してるんやないっけと迷う

Loraの追加学習ってできない?

細部のディテール詰めたいんや

LoRAファイル消しても適用され続けるってある?

なんかwebUI再起動したり色々やっても学習させた絵柄が消えない

>>347

三倍速になったらアスカテスト5秒切れそうやん

革命や さすがに画像の生成時間はGPUの性能に依存していてこれ以上減らないと思っていたのに・・・

なんなの?今まで本気出してなかったってこと?

>>347

これマジ?ワイの3060ちゃんが覚醒するんか sexのLoraって無い? アナルじゃない方の

プロンプトでしこしこ頑張ってるけどうまく出ない

TensorRTデフォにするといよいよNVIDIA以外は締め出されちゃうからONNXサポートして

TRTはonnxruntime側でサポートしてねになるんやないかな

1111のissueでそんな議論見かけた気がする

こんなんデフォで搭載案件じゃん なんのデメリットもないんか?

学習したやつ画像ガビガビになってる時は過学習って意味?

キレイな画質に飽きて汚さを求めてしまう

技術部で話してたけど詳しい情報を多く持っているモデルでLora学習するよりも無知なモデルでLora学習した方が良いらしいな

SEXとか体位のLoraを作るならNAI NSFWよりもNAI SFWで学習させるべきなんだと

>>390

insta、zipang、ElysiumV1、shirayuki general 何も知らないSFWにセックスを教え込むおっさんたち

7thV3AとNAI NSFWマージのckptにsfwにセックスを教え込んだLoRAを当てるってことなんかね

はじめに顔だけlora作って、ガチャで頑張ってエロポーズが出たらその画像を足して更に学習させる、っていう調教ゲームもどきで楽しめるぞ

>>398

LoRAは差分パッチだから色んなモデルに転用することろ考えるのなら

やや無知でフラットなモデルの方がいいね >>364

再起動してみてもダメだったんだけど、singularityコンテナから/dev/shmにアクセスできないでエラー云々という記事が見つかったので、-Cオプション付けてコンテナを実行してみた。

したらpytorch_model.binの保存スペースがないって怒られたので、sandboxモードで実行して、なんかようやく学習が始まりました。

ありがとう! >>370

これ、hello frogのデータそのまま使ってるのだけど、とりあえずこれで動いてるっぽい 背景白じゃなくて透過画像にキャラぼったちの画像で学習しようとするとめっちゃ警告でてくるんやな

一応進んでるけど大丈夫かこれ

>>398

なるほど道理で

プロンプトどういじっても性癖にあう上手いくすぐり画像でなくて

今日初めてLoraつくってみたんだが思っていたよりよく効くんだよなあ

もともとのモデルになかったからかな >>367

tensorflowのワーニングは、出ても特に動かないってことはないんよね。

よくわからん…… 某4コマでパラグライダーと気球をテーマの漫画投稿するつもりなんやけど資料用の絵はさすがに学習しないと無理やね…

けど空中から見た田舎の風景はそのまま転用できそうなのほんまai様々やわ

>>395

ここまでしてもらって申し訳ない

無事通りましたわ >>405

あー、-Cオプション付けたら明示的に$HOMEバインドしないとあかんのか。

だから保存スペースがないって怒られたんだな……

ヨシ!

AOM2を萌えエロゲ風の絵にするLora、昨日huggingfaceに上げたの以外にも色々試作中でさ・・・

左上がAOM2そのままの絵な?それ以外は今日学習したloraをいくつか配合を変えて適用したやつ

https://imgur.com/a/wSS12xA

まぁこれAOM2でやる必要は別に無かったというか、anyとかをベースにして学習でもいい気はするけど

ただ、AOM2の方が目指したい絵柄から遠い→学習元との差分が大きい→特徴が学習しやすいんだよやっぱ loraのオプションの--resolutionと--max_bucket_reso、--min_bucket_resoの違いってなんですか?

例えば学習用画像のサイズが2000×1500だった場合--resolution=2000,1500 --max_bucket_reso=2000 --min_bucket_reso=1500にすれば良いって事?

>>417

そんなんアップしてくれてたんかおもしろそうやな

層別LoRAできるようになったし早速試させてもらうわ >>398

NSFWよりSFWの方が知らんって前提には疑問符やなあ

確かにSFWは乳首もマンコも知らんけど島風の服とかvtuberの服はsfwの方が詳しい訳だし >>398

これ極端な話、素のSD1.4が一番プレーンだと思うんだけどそれでやってもたぶん上手くいかないんだろうな

無知なモデルの閾値が分からんな >>393

ガビガビなのはローカルミニマムか過学習かどっちかかなぁ

学習を山と谷があるところを谷にゆっくり降りていくイメージをしてもらうと、大きく見れば一番低いところじゃないけど小さな範囲では一番低くいところに落ち着くことがあって、学習率を一歩の大きさと見ると一歩が小さ過ぎて谷から出られなくなったりするのよ

で、検証用のデータの全平均みたいなところで落ち着くと人間の目だとガビガビなんだけどデータとしては良い感じ、みたいになっちゃったりする キャラ再現とか特殊性癖なLoraをどこで漁ってるのか知るためにAmazonに行きそう

>>418

resolutionは正方形の解像度

maxbucketはバケット処理でそこから変形させて伸ばす最大値

minbucketは縮める最小値

例えばresolutionに768、minbucketに640を指定すると

768x768の正方形画像を集める基本バケットの他に

640x920の縦長とか920x640の横長とか同じピクセル量で違う比率のバケットが作られるんやけど

1024x576というのはminbucketに引っかかるので作られん

これでどっちかの辺の最低解像度を保って学習の画質を担保できる訳や

同様にmaxbucketに1024を指定した場合

1280x460というのはmaxbucketを超えるので作られない

これで超縦長超横長の変な画像を学習せずに済む

ちなみにうまくバケットにはまらなかった中途半端な画像は一番近いバケットの比率になるようトリミングされるで >>419

いやすまんこの画像のやつはまだアップしてないんだ……

一応、昨日一個アップしたエロゲ風loraはこれな

https://huggingface.co/2vXpSwA7/iroiro-lora

画僧のはまぁ、今んとこ構図が破綻しやすい問題があってまだ調整が必要でなー

多分out深層が原因なんだろうから、そこ適用しないようなloraにしちゃえばどうにかなりそう

・・・なんだけど、今現在別の絵柄の学習回してて調整に取り掛かれないっていうね

なんで、これ終わったら一旦調整試す >>425

一部嘘書いたわ

stablediffusionの場合解像度の単位が64なんでバケットの辺もこの倍数に倣うから920とかは896とかに読み替えてくれ >>422

どうせNAIの遺伝子をもつモデルに対して使うんだから

NAI系で学習せんと噛み合わんぞ >>420

「学習させたい概念に対して無知」ってことじゃないかな?

体位とかだとsfwの方が無知なので白紙に書き込んだものがそのままloraの結果として取り出せるけど、nsfwだと近い概念が含まれているので、チラシの裏に書き込んでチラシの内容が透けて見えて混ざったものしか取り出せないようなイメージ

逆にキャラクタとかを覚えさせるならnsfwの方が良いのかも >>332,342

passが密着してしまったわね…

呼び出しプロンプトにreino pool入れて下さい

強さ1で普通のプールになったりするのに

人物入れても消えたりで動きがようわからん

学習モデルはbasil なんでcinnamonあたりと相性いいかも >>418

resolutionってのは要するに√最大画素数のこと

512なら26万画素で学習しようとするし1024なら104万画素で学習しようとする

,で区切って2つの数字にした場合はそれぞれを掛けた数字になるから512,1024なら52万画素になる、これの前後は実はあまり意味がない

max(min)-backet-repoってのはそれぞれの最長(短)辺の指定

resolutionに収まる範囲でその最長辺に収まる形にリサイズしてくれる

あんま深く考えずにresolutionの2倍とかにしとけばまあなんとかなる >>417

これアビスオレンジ用だったんか

もっかいチャレンジするわ Lora、キャラの再現度は高いものの、spread legsとか入れてもバストアップしか出ないな

過学習気味なのかな。TIとかHNみたいに数値調整できればな

プロンプト入れてもポーズが固い

背景にキャラの小物が生えてくる

絵がガビガビ

他にも危険信号ある?

>>433

できるっしょ

俺は作ったやつ全部0.7で使ってる LoRAの階層マージって別LoRAに保存出来ないのかな

強度0.8の状態を保存したい

あと学習済みLoRAに対して再学習かけたい

>>433

プロンプトLora呼び出しのところでも呼び出すための単語でもコロンの後の数値触ればその辺の調整はできる

ただシンプルに再現度も下がるからその辺の塩梅は難しいかも >>436

それこそ元のモデルに強度指定してマージすればええんと違うか >>417

なんかAnythingV3使えば良くない?とか思っちゃったけど……

たぶんワイが野暮なだけや キャラ再現の学習で透明正則化画像使うと再現度下がりやすくてなかなか当たりのモデルが出来んわ 正則化画像の学習回数減らしたかったら透明画像を学習画像に混ぜて1girlとかのクラスを表すキャプション付けとけばええんかなと思ったり

>>435,437

出来たのか!サンクス試してみるよ >>435

俺も同じく

<lora:hoge:1>とかでやるとくっそガビガビになるが

<lora:hoge:0.7>でやるとうまいこと中和されて元のモデルのきれいさが出るよね >>438

ああ、そうか

LoRAをくっつけてモデルにしちゃえば済む話か

それでSTなり階層マージして、くっつける前のモデルと差分LoRA作ればやりたい事は出来る……か?

くっつけた場合やそこから差分LoRA作った場合って呼び出しトリガー残ってるんかな 玉揉みLoRAとか後ろから手コキLoRAとか挑戦してるけど

キンタマが4つある東方定助

ふたなりを手コキしてる男

ベトちゃんドクちゃんの相互オナニー

みたいな絵ばっかり出てきて絡みはまだまだ茨の道だと実感して泣いてる

まず東方定助TIを作ってそれをNegativeに入れるみたいな所から始めるべきなのかもしれない webuiのsettings>Extra NetworksのApply Lora to outputs rather than inputs when possible (experimental)にチェック

かなりマイルドにLoRAの効果が適用されるで

1辺が448,512,578,640,704,768pxとバラバラな正方形画像の学習データがある場合バケットのオプション付ければそれぞれの画像をそのサイズで学習してくれるんやろか

>>449

resolutionが512でそれが全部正方形なら全部512x512にリサイズして学習する >>426

その前スレのやつ使わせてもろたで

ちょい弱めにかけてエロゲ風ではないけどAOM2っぽいアニメ絵ができてなかなかよさそうや

ワイは使わせてもらうばっかりやけど応援しとるで >>448

試しに今git pullしたけど生成できたからおまかんや

Extensionsとかvenv退避させて再起動しろ >>452

サンガツ

明日朝エクステンション避難してやってみるで >>450

サンガツそういう処理になるんかぁ とりあえずresolution=512でやってみて良い結果になるのを祈るわ そろそろAIお絵描きにもオカルト文化が導入する頃合い

モデルをキオクシアのSSDに保存してると生成される絵のクォリティに温かみが出るとかそんなの

お馬さんとなかよしヨシ!

スレ読んで気がついたけどtrain_resolutionを増加させたのに

max_bucket_resolutionやmax_bucket_resolutionを変更し忘れとった…

トホホ…また学習し直しだよ…

ところでエロシチュLoRAをもし公開するとしたらどこがええんやろな

HuggingFaceは流石に怒られるだろうし BatchSize上げると同時に複数の画像を学習するから、

回す回数少なくしても学習効果高いって英語サイトに書いてあったからやってみたが、

確かにクオリティ上がるな。

3060だとVRAMに限界あってすぐメモリーエラー出るから4090か3090に買い替えることにしたわ。

24GBなんかAI以外に使わんのだろうけど

TensorRTも今の倍必要という情報もちらほらあるし。

>>456

馬なら絡み作りやすい盲点

civitaiだっけ?どや RuntimeError: CUDA error: out of memory

とかいうNVA部最大の敵

SeagateのHDDに一ヶ月ほど熟成させることで学習モデルにゆらぎを与えイラストをよりアーティスティックなものに仕上げることができます

>>456

生成例の画像を上げたりしないなら🤗でも問題ないと思うけどそれもセットにしたいならCivilaiかmegaって人が多いと思う 各電力会社によってどんな絵が出るか比べてみました(オカルト)

kohyaのface_crop_aug_rangeとかhysts/animr-face-detectorとか使ってみたいけどコンパイル鬼のように時間かかってこりゃクラウドのインスタンスでやるのは無理だなぁって感じ

じゃあローカルでやろうかと思ってもそっちだとコンパイル始まりすらしなくて泣いてる

>>462

電力会社冗談かもやけど同じRTXグラボでもメーカーによって差が出るんやないか…? 画像2、3枚を水増ししてLoRAする方法って過去スレにあった?

あったような気もするんやが覚えとらん

クラウドの方も数十分のビルド作業の末にコケました

もういい!私facecropやめる!自分で生首を斬る!

>>466

つい最近だったのに忘れてたわ🤪

アレって服も出したい場合は別にLoRA作って併用する感じなんかね >>465

生首を512x512の中のいろんな場所に配置する奴はあったけどそれ?

それにしても二週間前からここ読み始めたんやけど

過去スレはどこまで読んだらいいのかわからんな

今年のスレは何とか読んだけど去年のも読む価値ある情報あるんやろか 俺は他人の努力の成果物を泥棒するだけのキモオタだからVRAM16GBなRTX4080でいいんじゃねぇの?と思わなくもない

4000番台発売でもはや魅力がVRAMだけの3090(ti)が値下がりゃ良かったんだがどうもNVIDIAはそれを許しちゃくれんみたいだし

>>465

学習素材を動的に編集しながら学習してくれるオプションがある

--color_aug (微妙に色を変えながら学習)

--flip_aug (同じく反転させながら学習)

--face_crop_aug_range (顔を中心に指定したサイズで切り取って顔のアップとして学習)

1番下の奴だけは別途追加のライブラリが必要なんだけどそれがインストール出来なくて困ってるのが今のワイや >>464

スピードとかなら差が出るかもしれない

アスカテストとかあるし流石に出る絵は同じだろう・・・ 実はグラボにありがとうって言い続けると学習が上手く行くんだわ

>>473

そんなんあるんか それも調べるわサンガツ >>458>>461

civitaiかmegaかサンガツ

まあワイ用に作ってるからどこまで汎用性があるか分からんが

ちょっと試してみるかmegaの方が楽そうやな パラパラ漫画の動画作るためにi2iかけたら16時間って

また明日

color augはどれくらい色変えてるんやろな 使っててほぼ色の問題ないからこのオプション入れてるけど1%くらいの確率で学習データとは全く違う髪色になるのはこれの影響やったりするんやろか

ロリキャラを巨乳にさせたい場合は絵をそのまま使うと身体も覚えちゃうから生首にする必要があるか

ペイントで雑に切り取るか

>>475

日本語だと効果がいまいちだった

やっぱアメリカ語でいわないとダメだわ キャラ覚えさせるときって結局キャラの特徴タグは残すんだっけ

>>479

あくまでvae程度しか変えてなかったはず

髪色引っ張られるのはむしろ帽子や髪飾りがデカいキャラがそっちに引っ張られた時ってことが多い気がする キャラの特徴は消すっていうか

残したタグに学習内容が分散されるのね

キーワード入れなくてもLoraが聞いてたのはほぼ絶対入ってる1girlに学習されてて

それがプロンプトに入ってるからだと学んだわ

黒髪じゃなくてもいいからblack hairは残しといいやってやってたら

black hairを入れないと効果が薄くなっちまった

>>481

また円安傾向だから日本語の力も衰えているのかもしれない

今はユーロ高だからダンケシェーンやメルシィが効果的と見た >>290

時間が出来たので試したけどこの順序入れ替えで無事dynamic promptsでLoRAガチャ回せるようになったわ

問題はアプデlするたびに直さないといけないところやね う~ん着替えさせたいとか体型変えたいからとかで首を切ったり、タグを消したりっていうの疲れるだけであんまりしてもしなくていい気がする

よしなが先生とかデータはこんなんばっかだけど、curvyしたらムチムチになるし、school uniformも着るし、バイクも乗る

>>469

去年の12月ぐらいかな

マージにハマっていた俺達の前に突如現れた merge-block-weighted-gui沼

そしてクリスマス前後のモデル配布祭

主要な情報はWikiにまとまっっとるけど、

当時の(今もやけど)手探りで叡智を積み上げていった流れは面白かったし

当時の知見は今でも役に立つと思うわ すごい

昨日からVroidで生首メソッド試してるけど

元がマスピ顔すぎて何の検証にもならない

生まれながらのマスピ女だよ彼女は

↓

↓

ただ

(1)キャラの特徴タグ(long_hair, brown_hair, ponytail, bow, hair_bow, black_eyes)みたいなのをプロンプトに打つと安定する

(2)それの入力の手間を省くためにタグを既成概念に結びつかない単語(ysnなど)に紐づけたい

(3)Taggerのテキストからキャラの特徴タグを消して、既成概念に結びつかない単語を先頭に追加する

っていうのはありかも?

>>482

キャラの特徴で呼び出しプロンプトに集約させたい部分は消す

プロンプトでオンオフさせたい特徴(衣服やアクセサリー)は残す

例えばこのキャラ を覚えさせたいときにはtaggerでタグ付けすると

を覚えさせたいときにはtaggerでタグ付けすると

1girl,kimono,hat,sash,black eye,white hair,gradient hairあたりが出てくるので着せ替えしたいなら

sen no rikyu,kimono,sash,hatみたいに固有の名称を呼び出しプロンプトとして追加して顔の情報のタグを消す

そんで出来たLoRA適応してkimonoとhat入れずにキャラ名と着せたい服をプロンプトに入れるとこうなる

、

、

ただし>>484も言ってるように多分だけど残したタグがそれぞれ学習してるからキャラ名だけでも元の服に侵食されるしkimonoやhatもキャラ固有のモノになる

kimonoとかhatをプロンプトに入れなかったりネガティブに入れると出てこなくなるのは汎用プロンプトとしての性質も持っているからだと思う 生首学習は顔を色んな位置に配置せず全部中央で良さそうだった

ただ解像度はちゃんと揃えた方が良さそう

解像度512*512で揃えた方

上の素材と顔の大きさ自体は同じだが解像度は顔の大きさに合わせてバラバラ

解像度揃えた方が画質は良かった

>>488

merge-block-weighted-gui沼w

どの層が何に影響とかって自分でやってみて感覚的につかむ感じ?

この前一日中やってみたけど、確かにこれは沼だなとは思ったわ

なんかわかったようで結局何もわかってないんじゃないか感がすごいんだが 自動タグ付けのままプロンプト入れたら対応した教師画像の構図がそっくり出てくるのは何が原因なんや?

指とかは破綻してたりするけどi2iパクリかよってぐらい似てる

っていうかフォルダの命名規則の「40_ysn 1girl」のidentifierってプロンプトに打つ必要ないんだな?

<lora:yoshinaga:1.08>とか打つだけで効いてる

これは複数概念を学習させたときに呼び出す呪文なんだろうか

って書いてたら>>484が書いてたわ学習なんもわからん

LoRAの極太輪郭線に困ってるニキ、bad-artist-animeのネガティブを強めに効かせると少し軽減されるかもしれない

本来学習で解決すべきところ半ば対処療法やが...

>>497

フォルダ名はキャプションtxt付けた時点でプロンプトとしては意味無くなるってりどみに書いてあった

そんでキャプションがtaggerで付けたのそのまんまならそれぞれのプロンプトが汎用プロンプトの性質を持ちながらもキャラ特徴の呼び出しプロンプトになる >>489

って言うかそれってMMDみたいなものちゃうの?

それなら色んな角度とか表情させれば幾らでも素材増やせると思うんやけど 素材増やしたところでこの量産型フェイスがlora学習かマスピ産なのか我々に区別つくだろうか

>>493

モデルによって違いがあったり、今でもはっきり解明された訳ではないんだが、

なんとなくこんな感じちゃうか?みたいな知見はWikiの階層マージのページにある通り

AIとか深層学習詳しい人もいれば、ワイみたいに雰囲気で知ったかで遊んでる 途中送信してしもた。

ワイはなるほどわからんと言いつつ真似して遊んでるだけなんやけど… 後で読み返すと前は分からんかったことが分かる瞬間があったりするな

ここの皆の謎を解き明かしていく、観察 推論 仮説 検証 考察 そして情熱はマジですごいなといつも思う

paperspaceで楽しく遊んでたらstorage使いきってて請求増えたンゴ…

>>242

貴公の設定でBLEACHの夜一さん作ったら中々ええ感じにできたで!

でも険しい顔ばっかにしたら険しい顔しかしてくれなくなった...

>>506

webuiやモデルは非永続ストレージに入れてるか?

容量を節約できるし永続でやるより生成が速くなったで

paperspaceの永続ストレージは遅いわ >>508

1分くらいかかるしなんならモデルの階層移動する時に複製してたりしとったぞ…

非永続のやつ調べるわ ワイがシコシコVroidStudioで作ったキャラもマスピ顔になってしまうんかと思うと怖くて寝れんで

>>509

/storageと/notebooks以外が非永続ストレージや

接続切れると消されるから

設定だけ永続に入れて非永続にコピーするようにしとくとええで youtubeにスクショ取れるボタン追加するchromeの拡張機能便利やな 画像検索より使えそうな素材集まって助かる

>>511

notebooksの直下で構築するだけで苦労したのにそんな高度なことができるのか!?

後日ログ漁るわ てか外人の見てるとこんなん入れて結果に影響出ないのかってのも学習対象にぶっ込んでるんやな

画力とか表情とかそんなに拘る必要もないんか

今日もフロストノヴァを生成して就寝や

アークナイツキャラそこそこ作られてるから240GBに入ってるかと思ったがそんなことは無かった

さすがに中国人コミュなら作られてるんだろうけど

階層Lora試しとるんやけどやっぱ有用やな

調整次第やと思うけど塗りだけ消すみたいなことできるっぽい

>>513

としあきwikiで紹介されてるvoldemort使えばええ

正直ここまで長い必要があるのかは分からんが全部自動でやってくれるし

今のバージョンならmodel_storage_dir = '/storage/models'をmodel_storage_dir = '/tmp/stable-diffusion/models' に書き換えるだけでモデルデータは一時領域送りになってくれる

起動の度にDL必要やけど一時領域はDL早いからワイはそんな気にしとらん

huggingfaceのモデル使いたいときには

%store -r symlink_to_notebooks model_storage_dir repo_storage_dir

!wget 「使いたいモデルのダウンロードurl」 -O "{model_storage_dir}/「モデルのファイル名」"で使える

自分でモデルマージするとそれは永続に入るからそこは注意や

supermergerとかで気に入ったのできるまでガチャできるようにしとこう

vaeも一時領域送りできるけど大して数もないしproコースならこれは永続ストレージでええと思う >>518

脳死でアレに従ったらよくわからず詰んでたんだけど今なら大体なにが何かわかったしいけそうな気がするわ

とりあえずマージは諦めるようにするわ >>519

supermergerなら保存押すまで生成したモデルをストレージじゃなくてメモリに一時保存するからかなりマージで遊べるで

proコースならモデルデータ2つ3つぐらいは永続に入れられるから

supermergerでガチャ→厳選したモデルだけ保存してhuggingfaceにアップ→永続ストレージのモデルは消して次回以降起動時にhuggingfaceから一時領域にダウンロード

ってワイはやってる >>501

.captionのキャプションつけると無効になると思ってたけど挙動的にそうなのかもなあ >>504

やっぱそうか

今年になって始めたからプロンプトとかもテキトー

今は短いのがいいとかいうのもよく聞くけど

MAJINAIとかで見ると長いのでいいのもあったりで

結局AIにはまだ必勝の方程式みたいな近道はなさそうやね、、

一応一通りのことはできるようになったから焦らずのんびりやってみるわ >>520

こんなんあるんか賢いな

とりあえずページファボっといたわ 絵師画風再現してみようと思って学習300枚正則透明100枚突っ込んでみたわ

人物は良い感じだけど服とか小物とかぐちゃりやすくてH系は良く言われてるようにポーズ取らなくなるなぁ

どうすりゃいいんだろタグで改善よりLora層別マージの方がええんかな

割と真面目に手描き絵師の7割が要らんくなる勢いやな

二次創作は特に

アホかその7割がAIも使ってくれたほうがエエわ筆を折られては困るで

今いきなりAI絵を出すと後ろ指刺されるから、技術に乗り遅れないようにこっそりAI使ってる絵師も結構居そう

元々二次創作界隈自体がグレー攻めてるんだからAIに拒否反応起こすのもよくわからんね

AI使って絵師煽るガイジやPixiv侵食しまくってるのは死ぬべきだが

手コキlora作ろうとしたらパイズリloraになって草

でも下半身とモザイクはちゃんと学習してくれてるな

貧乳しか描かない絵師

エロは描かない絵師

ひっそり爆乳にして脱がせる背徳感・・・を目指して頑張るぞい

長チン問題や男が出ない問題の方を解決してほしいなァ

>398

技術部ってどこにあるんや?

>449

一番下にvenvフォルダーを消して web-user.bat を実行したら解決したで、って書いてあるで。

英語の翻訳はDeepLがおすすめやで。

>486

そんなときは git stash が便利やで。

git stash で変更を一時保存 → git pull → git stash pop で変更を書き戻し ってできるで。

そやけどgit pullの時点で変更が必要な場所が変わっとることもあるやろから注意やで。

メインメモリ16gだとブラウザから

stablediffusionの黒い画面まで全部閉じないと

学習中ページファイル不足でエラーになってたけど

48gにしたらクロームタブ開きまくってYoutubu見ながらでも余裕だわ

今メモリ32gで1万円だからオススメ

wuiってsysRAMってそんなに何に使ってるんだろ

weightのRAMキャッシュやらせたりメモリ上でマージさせるとドカ食いするのは知ってるけどそういうことさせないで普通にやってる分には16GBでメモリ不足になったことないというか

むしろ2個8GB分くらいまでならキャッシュさせてもページング必要になったことがないのだけれど

なんでだろ?クロームでタブ開きすぎとかなんかな。

でもlora学習開始前で16gのうち3割くらいしかメインメモリ使ってなかったと記憶してるから

loraのやり方の違いなんかな

どこかのWikiにも書いてあるけど

Chromeを始めとするブラウザ系は設定で「ハードウェアアクセラレーション」を切らないと

1タブ開くごとにビデオメモリ持っていかれるよ

まぁ、何に多く使われてるかはWindowsならリソースモニターのメモリタブを見たほうが早いかな

スタートメニュー→Windows管理ツール→リソースモニター

あ、ビデオメモリとメインメモリごっちゃにしちゃったかw

リソースモニターはメインメモリの確認ね

学習が本当にちゃんと上手く行くかは512で試して成果を見たあとで1024やる方が本当は上手く行くのだろうけどいきなり1024でやっちゃう

生成ではいきなりhiresには否定的でまず小さいサイズでseedガチャやってから良さげなのを厳選した後にhiresする派なのに

ダブスタですね

>>520

supermergerキャッシュできるんか、最高やね

今度ぜひそれ使ってみるわ 特定のフォルダのPNGをまとめてjpgにするツールでおすすめある?

PNGが数千ファイルになってきて地味に容量を圧迫してるんよ

>>540

アップスケールexrtraでやってるワイ少数派なんかね >>539

お~v2-Cとか本当にプレイしてた頃エロゲ塗りだわなんかゆずっぽいというか

色々試させてもらうわサンガツやで 自分ならimagemagickでやるけどCLIなのでおすすめはできないな…

>>542

再出力できなくなってあとで困るんやないか?

同じ画のバリエーションも作れんくなるしとっといたほうがええで LoRAって結局何者なんか知れるサイトとか無いか

やりたい事に対してどんな画像を何枚用意してどんなプロンプト載せたりしたらええんかいまいちわからんねん

崩れた絵だけ検出できないもんかね

ハイレゾガイジだから9割の画像が手足グチャってて見直すのつらいわ

>>549

手動でいいならPhotoSiftがええよ

高速で画像をフォルダー分けできる うちのtxt2img-imagesフォルダのプロパティ見たら6万ファイル超えとったw

まあ、半分はテキストファイルなんだけど

>>542

いや、おっしゃるとおりなんやが、容量が圧迫してきてバックアップでPNGは退避予定なんやが、一括してフォルダのPNGを定期的にJPGにしてiPADでネットワークビューワつかって抜きたいんや 自分はmpvでluaのスクリプト書いてxキーは消し、zキーは所定のフォルダにセーブ、みたいなの書いてるけどpythonばっかやってきたからluaすごく書きづらい

ロリキャラにしたいのにlatentでhiresかけると眼がちっちゃくて外寄りなってロリ感じ失われちゃうのってどうにかならないもんかな

>>555

失われるぶん前もって強調したらどうなんや? 最近はハイレゾ掛けると壊れるぞとハイレゾ掛けないと壊れるぞがあってややこしいわ

その2

作った後で気付いたけどマシュビーストは有名衣装やからわざわざ作らんでも素で出せたかもしれん 動物手袋はめると指の破綻が気にならないと言う知見を得た

素で出せるやつは素のタグも入れれば精度爆上がりする

背向けフェラでこっち見んでええのにこっちばっか見続けるのはどうしたらええんや?

もちろんポジにlooking at another:1.5入れてネガにlooking at viewer:1.5入れとるんやが

Lora面白いけどこれはなんだか規制きそうな気がせんでもないな

生首学習等、背景なしで学習すると

背景描かなくなってしまうんだが

モデルによっては大丈夫なの?

>>555

めんどくさいけどdenoising strength低め(0.3)程度の絵も出して目のまわりをそいつから移植するという手もあるで 二次創作あたりは規制入りそうだなぁと思っただけ

自分で使う分には大丈夫だろうけど

敷居がどんどん下がって必要枚数も減るやろから

即座にパクられて海賊版作られかねんからやろな

でもそういう商売するのは外人や無敵の人やから規制しても何の意味もないやな

でこっち向きやがる問題どうすりゃええねん

>>564

プロンプト全文分からんとなんとも言えんが背向けならfrom behindとかちゃうん?

looking at の時点で暗黙のviewerが効くし

目の方向が分かる=顔が見えてる=後ろ向きなら振り向くか横顔になるってのもあるやろうし 海賊版で商売して公式からストップ入るんはAIも手描きも一緒やろ

同人トレパクしてネット学級会で晒し上げられるんも一緒や

何日か前にここに貼られていたアプリで、画像からいらないもの(不要部分やゴミ)をきれいに取り除くって物があったと思うんだけどそれってなんだっけ

使いたいんだけどページや名前を保存して無くて履歴からも探せない

>>564

モデルにもよるけどどっか向かせるのはlooking awayとかやないの? >>571

もちろんfrom behind:1.5やで

でもこんな感じでこっち見やがんねん

ペニの方向けやって感じや

>>573

lama cleaner?字幕は綺麗に消えるな ゴッゴルコラッボでォラ学習させてるは ……

これ簡単やな・・

>>575

目とか顔に効くプロンプト使ってるとコッチ向く頻度増えるかも プロンプト内の他の要素が効きすぎとるとか?

1.5ってかなり強いと思う

>>580

あ~そういう

細目にするために入れとるからそれの影響か ゴッゴルコラボの羊が死にそうなんやが・・・

持ってくれよ……頼む……

>>579

メインも使う

16GBやとVRAM12GB活かそうと思うと足りない >>575

今ダンボールで見てきたがlooking at anotherって目線がViewerじゃないだけで顔が表向いてる絵ばっかやな

Negativeに目とか顔の要素も入れるといいかもしれんね >>584

知らんかったわサンガツ

16Gしかないンゴ

増やさないとあかんな! 明日は休みだ、帰ったらpaperのloraにxformers使うの挑戦するんだ

>>575

face turn awayじゃあかんか? 学習のパラメータをいろいろ試しているうちに気付いた

俺はアニメのマカちゃんを作りたいのではなく

イラストのマカちゃんを作りたいのだと...

1枚の絵から学習してみようかな ジオン系のMSは全然出ないから試しに色んな水陸両用MS学習させてみた

ジオンっぽい車が海辺を爆走するLoRAが生まれた

多分背景の車両とかもmechaやweaponでひとくくりにされたせい

Lora同士をマージとかって出来ないんかね

世界中の学習ファイルを集めたLora玉とか作れたらええのにな

>>593

本来の目的とは違うんやろけどこれはこれでええやん そもそもLoRA技術を使って最初からモデル作成ってむりなんか?

モデル作成は計算量かかりすぎて難しいから

SDで追加学習が流行って

それよりももっとライトなLoRAが今流行ってるんだよ

個人で1からやるより有能なベースモデルで追加学習した方が良いと思うわ 少なくともワイがやってもcool何とかみたいになるだけや

>>596

最初からは無理だけど、作ったLoRAをモデルに埋め込む(モデル生成)は出来る

というかそういう使い方が本来の使い方 Loraのマージはあるやん

使い道がわからんけどな

>>585

そうなんか

いいワード思いつかんで・・・

逆にネガにlooking at another入れてみるか

>>590

いけるかもわからん

試すわサンガツ ローカル導入して余っとる250Gのssd使ってまあ半年くらい持つやろと思っとったら二ヶ月で足りんくなった

大容量なhdd買おうと思っとるけど制作するスピードに影響あるんかな?

1から自作できる環境があったとしてもNAIちゃんが強すぎてな

今主流のモデルはほとんどNAIちゃんの子供や

くっそwwwwおっぱいがボディペイントみたいになってワロタw

>>605

HDDはやめとけ

せいぜい150MB/sぐらいしか出んからモデル切り替えやらLORA読み込みやらが遅すぎて発狂する

逆にそんなに速度出して何するんやと言われるNVMeの本領発揮する分野やで 使わないモデルの退避場所にはええよな

SSD1Tあってももう溢れそうや

>>606

web版からローカルへ完璧なコンバートさえできればなあ

強調などの差異からweb版で出てた微妙な表情がローカルだと別物になってしまう事も多い

輪郭や構図がほとんど同じでも表情が再現されないんじゃ意味がないんだよなあ

そしてそれが{}の数のズレ、{{{girl}} みたいなミスによる偶然の産物だった場合再現は絶望的になるという・・・ ワイもHDDにはあんまし使わんモデルやらLoRAやら生成した画像やらを置いとるな

4TB買って当面安泰やろと思っとったら2ヶ月ちょいでもう1TB切ってもうたわ…

HDDは使わんモデルと環境のバックアップ兼画像の出力先やわな

ワイ、modelsフォルダだけで600GBあったわ

使わんモデルはどこかに待避させんとSSD溢れてまう

ワイは6TB2つに突っ込んどる

ssdいつぶっ壊れてもいいように1週間に1回はBAしとるで

大量のLoraを内蔵した一つの巨大モデルみたいなのがあれば少しはストレージ問題もマシになるんやろかね

HWmonitorとcrystal Disc infoは欠かせない

VWバスと水陸両用の融合を感じる

うーんこれはジオンに兵無し

>>622

これちゃんとMSだせたらガノタにめっちゃ需要あるんやないか? 人型ロボの学習ってclass promptを1boyにしたらええんかなぁ

皆今のLoRA天下が今後も続くとでも?世は戦乱ぞ?

この辺のさらっとMSV-Rに追加されてそうなのが出せると面白い

今の奴だと全然安定しないけど

>>625

検証助かるで、dim多いときは素材選びが大切っちゅーことか >>625

こういうノウハウや知見まとめは本当たすかるやで マルゼンスキームの良し悪しより結果出るやり方ってのがでかいわ

>>620

LoRA複数重ねると崩壊しやすいしそもそも原理的に無理なんだと思うで

過学習ぎみに作って強引にキャラ出してる場合とかも多そうやし

今は学習データを既存モデルに重層的に重ねていくんなら

StabeTunerでやるしかないんじゃないかな いい加減さっさとmegaのファイル全部落とそうと思って課金したんやが

転送量制限は緩和されてもDLしまくってると回線絞られるんやな

騙された気分だわ

WDBlackの2TBを2.5くらいで買ったばっかやから損した気分になってもうた

paper新規登録タイミングは今でええんか?

タイミング悪くて先月分取られたりしない?

>>625

やっぱりマルゼンスキームというかトリガータグに集約させたいタグは消すってやり方でちゃんと着せ替えとか髪型変更可能になるよな

学習次第で元の服の断片残るけど

4chでも同じこと書いてるのにたまに逆って言い出す人がいるのはなんでなんやろね

一番最初の文章すっ飛ばして画像と文章が一項目ずつズレた状態で読むと確かにそういう勘違いになりそうやけど >>641

時差怖いから2日加入、解約は月末2日前にしとけ

何かあったときに安心や リアル系モデル持ってないからリアルニキはガッフェ試してくれ

グロ画像になるかもしれんが

>>647

せやな…特に急ぎでもないし明日にするわサンガツ >>639

これhires.fixしても耐えられるん? 小さいペニスとかショタペニスloraほしいけど全然見当たらんな

>>653

512→latent 2x denoising 0.6

わざと学習タグ増やした(threshold 0.1)ので汎用性は高いはず >>657

すごい

こんなん先端の亀頭は譲らないやんけ >>657

すまんパスわからん

nanjやないんか >>659

シャープから後の文字列入れたらいけるやつちゃうんか >>657

上手くいかないんだけどワイだけか?

majinaiにくれや ちょっとスレから目を離したらすぐ赤ちゃんになっちゃうの草

>>644

silver hairとかbangsとかのタグを消せばいいんよな?

1girlやsoloも消した方がいいんか? >>655

こういうのじゃなくて野良ヒグマのみたいなんがほしい

けど絵柄ええ感じにしてくれるのはええわ >>661

1girl fellatioだけで行けるはずやが 浦島太郎と赤ちゃんを踏み潰してるメスガキ美少女なんJ民の画像ください

>>665

そういうことや

1girlとかのタグ消さないと1girl入れるだけで学習させた衣装がランダムに召喚されると思う novelAIでもガッフェはダックフェイスいれればできたな

basilでガッフェLORAやったら棒の知識が薄いせいで謎のボヤボヤした肉棒を頬張ってるだけになったわ

ここら辺いいモデル無いんかな

>>670

サンガツ

たくさん作れば当たりもあるやろの精神で使こうてたけど

おかげ当たり増えそうや >>665

ワイは1girlもsoloも消してる

特定のキャラ単体で出すときに「そんなん入るに決まってるやん」みたいなタグは全部消してええと思う

普通のプロンプトに学習内容分散させまくってもしょうがないし

海外のLoRAでドルフロのやつとか見ると基本スキンはキャラ名だけがインスタンスプロンプト、他のスキンはキャラ名&スキンタグがインスタンスプロンプトって感じでほとんど余計なタグ無しで一つのLoRAに複数コンセプトが入ってる

>>489

boothでモデル買うのもいいかもVRM形式で配布している人もいるし 画風学習の時って出てきたタグ全部消さん方がええんかな

>>677

画風に関わるタグがたまに入ってくるからそれだけ消せばええやろ

後は特定の服装や物が多い場合はそれを確実にキャプションに書いとかんと出てくるようになるで >>678

なぜかめっちゃ傘持っとったからumbrella消したわ

メイン10枚正則7枚やけどいけるんかなあ不安や 全然関係ない画像貼ってしまった

ドルフロLoRAのタグの例ね

PA15がキャラ名

画風の時はマジでウォーターマークは画像から消した方がいいわ 焼き付く

もう「竿役はチンポ以外一色でいい」

そうは思わんかね? 竿役がショタで女体にしがみつくような感じでヤれるLoRAください

>>682

あかんかまいたちの夜思い出してわろてまう toru and hundred ninja,

mari and higuma,

手持ちで作ったパイズリLoRAが咥えが甘かったので組み合わせてみたい

女の子もかまいたちの夜風のシルエットにしたら一部で需要ありそう

>>689

自動でアップデートとかしてくれないんだから自分で作るか誰かが作ってくれるのを指咥えて待つかの二択やろ ガッフェlora使い方もうちょっと詳しく

nai fullで学習、生成はcinnamon mix

出したいキャラの公式画像とかをinterrogate deepbooru機能通してプロンプトに

キャラloraはとガッフェloraは結果次第で両方調整する必要がある 以前TIで手の形決め打ちで覚えさせようとした時は上手くいかんかったな

例えばグーチョキパーそれぞれ作って描きたい絵に合わせて使い分ける方法や

もしかしてloraなら上手くいくかも

ギルド職員の某堅物エルフを再現できた

当然nsfwになってもらう

最近お気に入りのlr1e-5、遅いが安定してるんや >>684

まだ過学習なとこまで進んでないから混じりがちやけどな

多分ぶん回し終われば近づけると思う >>691

多分LORA配布する時は最初から

「入れとけ」のところのLORAの中身を確実に呼び出すためのワード群

学習させたモデル/自分が使えると思ったモデル

の二項目は配布と一緒に書いとかんと反応悪いと思うで >>494で自作LoRA置いたけど無反応やった

中にサンプルや呼び出しタグとか確認済みモデルとか置いたテキストも設置済みや

まあネタがマニアックすぎるからしゃーないけどなガハハ 元の衣装要素が着せ替えにいい感じに混じってキャラに合わせた衣装アレンジっぽくなったりならなかったり

ハイレゾで2倍にするのとi2iで2倍にするのの違いってどの辺にあるんか教えてクレメンス

ハイレゾはガチャ要素が強いイメージあるんやが、上手くコントロールできるもんなん?

>>700

それ追加文字列が「=」(全角)になってる気がするので半角に直した方がよさげ >>704

Latent系がガチャ要素強いだけで他のアップスケーラーはそうでもない

i2iのアップスケーラーはデフォでnoneになってるだけでこれもsettingから変更できる 正則化画像用意する時って512×512じゃなくて768×768でもええんか?

>>697

3090つこてhires*2したやで~

過学習調べるときにhiresしてLoRA未適用と適用済みを比較しとる。今回のは成功ぽいわ >>639

ありがたや

これautomatic1111で動かす時は既存のモデルに結合しなきゃいけない感じ?

たまに<Lora:ほにゃらら:1>で使用LORA選べそうなプロンプト見るけど結合しなくても使えるのか ハイレゾガチャ部に入部したいんやが

アップスケーラーの比較画像ってあったりするんか?

というか各スケーラーの特長ってなんや…?

>>709

>>691のExtensionみんな使ってるわけちゃうんやな

必須かと思ったわ

kohya-ss/sd-webui-additional-networksのやつ >>706

そういうことなんか

512で出力・選別してから解像度アップかけとるワイのようなスタイルやとi2iでええかって感じるけど

t2iのタブ内で完結できるのがメリットになるんかな DBでやった画風再現モデル、Loraでも試してみるか

DBで作ったモデルでも画風の再現度はかなりいいけど、キャプションとか使わずにwikiにあるやり方で作ったから多分Loraのほうが使い勝手がいいはず

Colabでgoogleドライブからloraフォルダにファイル移すのってどうやったらええんやろ…

2時間位格闘したけど分からん😭

two side upのパターン豊富過ぎてプロンプトだけやと再現難しかったキャラや LoRA様々やで

>>712

というかt2iのアップスケーラーでもnone選べばi2iと一緒や

いや正確には出力条件違うから細部は異なってくるんやけど拡大の方向性は一緒でグチャったりはしない

あとは二次元系ならanime6Bはいい感じに絵を保ちながら線や陰影をはっきりさせて拡大してくれる

というかアップスケーラーとしてはt2iのデフォのLatentがちょっと異質

ノイズも潜在要素も拾いまくって再描写するから美麗系のモデルでうまくいくとゴージャスになるけどクリーチャー生まれまくるしシンプルアニメ系のモデルだと服融けたり線ぼやけるだけ >>710

一応ぱっと出したのでこんな感じ(速度重視で今回は1.5倍だけど)

Denoising strength 0.56

大体のやつはあんまり変わらんけどSeed固定でガチャりたいならLatent系でええ >>678

そうなるとソシャゲキャラ画像から画風を作ろうとすると

イラスト内のエフェクトや手持ちの武器や装飾とか細かくダグ付けしないと駄目そうだな

本体以外の情報が山盛りのイラストから正しく学習させるのは難しそう 画像1 キャラ名、適当に名付けた服A

画像2 キャラ名、適当に名付けた服B

とかやれば服の方にいらない要素が全部行くのでは

知らんけど

>>701

アナルゼリーニキか?

ワイは前の穴より後ろの穴の方が好きなくらいやからガッツリ使わせてもらったで

やっぱ??出てくるよりもぜりーの方が抜けるわ

今は人格排泄表現しようとレイプ目とか涎とか下がった口角とか

狙ってでてこないかprompt試してる

新作期待しとるで! >>714

左のフォルダマーク押してツリー出てきたら

4つ並んどるとこの3番目のフォルダに△マークあるやつ押して

マウントコマンドでるから実行してパスコピーして

!cp スペース コピー元パス スペース コピー先パス

でこんな感じやろ多分知らんけど出先やから自信ない SDガンダムを学習させてみたけど方向性を間違ったみたいや

>>723

これが本当なら構図LORAに革命が起きるやん? >>721

ありがてえ!使ってもらえてサンクスやで

人格排泄要素は抜いて作ったからなぁ…今度検討してみるわ

トレイに持つのとかも含めてやらないとな!ぐへへ >>716

サンガツ

ひとまずアップスケーラーもいろいろ試して自分に合うものを考えてみるわ LoRAってハイレゾ時の破綻も軽減できるん?

今のところハイレゾが最重要でそれ以外興味を持てんのやけどLoRAがハイレゾもカバーするならやるしかない

>>711

ありがとう、俺が知恵遅れなだけやな

入れてみる >>709

>>711 の拡張入れてHNと同じように指定できる感じだったかな

タグ入力しなくて良くなった分、花札アイコンからのダブクリ挿入時は:1なので、↑↓で数値いじる時に範囲選択がちょっと手間になったかな

数値入力すればええんやけど

挿入時に右クリから数値で0.〇〇選べたら便利かなぁと思ったが、人によっては1/100指定してるだろうから修正案まとまらずくすぶってる俺 >>723

構図と絵柄の層は完全に分れてるわけじゃないからどうしても絵柄への影響はあるで

ギャングスタポーズだけ抽出しようと頑張ったけどどうやってもジョルノな部分が残ってしまったりする

まあそれでも層別Loraはかなり有用や LoRAでキャラ学習を試みてるんやけど、

局所最適に陥るような場合って、条件設定が同じでも試行ごとにモデルの出来が変わったりするんかね?

まあそんな簡単にLORAで構図出せたらpixivがどすけべエロイラストで溢れてるわな

>>733

せやろなあ

階層マージもそんな感じやったし >>732

おお、丁寧にありがとう

今までHNばかり使ってたからLoRAに乗り遅れた なんか厚塗りじゃなくてラフに塗ってる感じの出したいんやがそれに近いモデルとか知ってるやつおる?

これも覚えさせるのが早いんかな

>>701

いや待ってくれ見逃してたわ

アナルピースもできるのかこれ

神や >>719

まさにソシャゲの立ち絵から画風ごと学習させるのを狙ってるんやが

そうなるといっそその絵師の絵全部ぶち込んでキャラ関連のワード全削除くらい気合い入れなあかんのかな LoRAって呼び出しワードいるんか?

既存のワードで呼び出せる(例えばNSFW)様にしとけば説明せんでも出てくるし要らなかったら外せばええだけやしなんも困らん気がする

ガッフェしすぎて壊れちゃった… >>605

画像や学習結果の保存フォルダだけ

シンボリックリンクでHDDに出せばいいよ >>741

それでも行けるしお手軽ではあるんやけど

概念が元々強いワードに何か覚えさせようとするとあまりうまくいかんのと

複数LORA入れたときにトリガーをプロンプトのどこに置くかとかトリガー+部位指定とか使って調節が出来なくなるから

自分で作ってるのは全部トリガーに集約するようにしとるわ よくわからんがなんとなくわかる

>>740

139スレの458 654 680を参考にして欲しいんやが、特定の意味不な文字列(nfdkkcjejとか)に対して、背景、背景の画風、キャラの特徴、キャラの画風、構図のクセと全てを学習させるということが出来とる。せやから、もし多様な立ち絵を沢山用意できるなら、逆に細かい多くのことまで意識せずとも、混ぜられて一つ一つの概念が希釈され、いい感じになるかもしれん。からとりあえず簡単な1つの単語だけでやってみてはええんやないか?

立ち絵だとどうしても立っている全身絵ばかりになるやろから、standing, full bodyなどはタグに入れた方がよいと思うわ(実際に生成で使う際、プロンプトにそれらを入れない為に)

背景も全部一緒だろうから、生成時にその要素を上手く捨てられそうに出来るといええな。ワイは今、立ち絵の透過素材のタグに「transparent background, simple background」と入れておいて、生成時にはこれらをネガティブに入れておる。こっちは未検証なのでこの方が良いかどうかはよくわからんで。 >>740

会話シーンで使われる立ち絵の切り抜きとかなら問題ないと思う

ただキャラ画面で出るイラストは相当キツイだろうね

典型的なのはパズドラやモンストみたいなゴテゴテの1枚絵

>>723

自作のモンスターloraにパロットかけたけど酷かった

any系なんだけど殆どの階層でモンスター娘みたいなのが出た

流石に深層のMIDDでは完全なモンスターになったけど他はほぼ全滅

メスキャラばっかり過学習された弊害がモロに出てる

>>622 や >>724 のメカニキでも似た結果になると思う >>654

4chan lora-listの Flaccid phimosisが製作者的にふたなり用だけどそれっぽいで

あとニキのLORA使わせて貰ったで

サンガツ!

教えてくれ五飛

正則化画像に学習したい絵を入れて学習してプロンプトなしで出てくる絵は

学習画像の特徴を完璧に捉えた絵が生成される

もう意味が分からない

正則化画像は学習データ適応しなかった場合の絵はこっちなんやでって教え込む絵だから

正則化に学習したい画像入れたら制御不能な形でその絵が出てくるのは当たり前なのかもしれない

あ、これ衣装Loraの正解学習方法だわ

ついに発見しちまったわ

あれやってることほぼ学習そのものらしいからな

最近は正則化する代わりに公式にない衣装の二次創作絵にキャプション細かめにつけたの2割ぐらい混ぜて学習させて自由度出せないか試しとる

>>751

>>752

サンガツ

割と思い違いもあったみたいだから気軽にやるやで

立ち絵10枚×10繰り返しで正則化は8枚くらいでまずやってみるわ

意味不明文字列に読み込ませるのええな、使いやすそうやわ >>714

フォルダツリーに表示されたdriveフォルダの中にlora入ってるからマウスでDDでもファイル動かせるぞ すまん未だに混乱してるんやけどキャプション(大体の場合.txt)を用いる場合

前提として呼び出しタグを一つ先頭に用意してそれ以外をシャッフルはするとして

例えば画風を学習させたい時に小物とか髪型とか服飾がバッラバラやけど

これらを.txtに対して記載した方がええんか?逆にしたらあかんのか?

ここがま~~~じで理解しようとしても頭がパンクする

Dreamboothで過学習したときよく正則化画像のトレパク絵みたいなの出てたわ

>>305

お前天才だな

自分の身体を取り込めば一生オカズに困らんな 落書きから構図を読み取って生成する技術早く来て欲しいわね

NAIのpruned付いてるモデルってfp16なん?

Toolkitでfp16でデータ削減したモデルで画像生成しても完全一致するんやけど

演算精度変わらないなら軽くしておきたくて

>>767

これいいな。類似した冗長なタグの扱い方とか参考になった。 >>639

はえ~すっごい どうやったらこんなに汎用性持たせられるんやろ

にしても1年経たずにここまで出来ると数年かからずに動画のキャラ差し替えとかできてるかもしれんな…

その前に何らかの法規制されるかもだが

>>771

雑コラディープフェイクレベルなら数年前からあるやね

ニュースでよく取り上げられるゼレンス〇ー劇場の程度の動画なら音声用意すればここの住人ならすぐ届くところにあるさ

アニメでいうとキャラ以外の背景も著作物なので表立ってやるやつはいないと思うけどね

モラルと興味と時間のバランスだろうけど、世界中の振り上げられた拳と悪意を呼び込むだけのりあるおっさん動画を延々と弄り回したい人は少ないと思うしな(笑) ディープフェイクでアニメキャラの顔だけ挿げ替える研究はされてたけど微妙だったなあ

画像AIは顔だけじゃなくキャラそのものを再現できるようになったのはすげえわ

動画はまだ厳しいけど所詮は一枚絵の集合体やから時間の問題やろな

公開されて5か月でここまで進化するからなー

2025年には特異点くるかも言われてる中でAI規制しますよなんてやったらまじでおいていかれそう

エロ目的でやってるうちは大丈夫よ。誰かを貶めるために使われ出すと危ないと思うけど

学習データが極端に少ない(キャラの正面絵が無い、など)場合は、むしろタグ多めにつけてランダム性に任すのもありに思えるけど、実際どうなんだろう

今日試してみるか

変にrabbit earsなんて固定にタグに入れてたからピンク色のうさ耳出してきたわけや

真逆のことしてた

生首学習法うまくいかんな、生首だけに加工してキャプション特になし、インスタンスにキャラ名クラスにgirlでやってるけどたまに生首生成するわ

汎用性持たせるには要研究か

やっぱ素材少ない生首Loraは、ランダム性持たせるためにタグはそこそこ要ると思うわ

逆に生首loraでも、頭の全方向カバーできるとかならタグをどんどん削れそうだと思える

>>779

close-upとかfaceとかのダグは付けた?

頭部と認識させないと結果が生首だけになるんじゃね?

知らんけど(生首打法未経験) 公式と二次をごちゃ混ぜに30枚ぐらい集めて

キャプション一切無しで10_(トリガー) 1girlで学習にブチ込んで雑に満足しとるクチなんやけど

同類はおらんか皆志が高いんやな

>>782

この方法した場合って、顔の方向(傾き)とか髪型の向きとかが、学習データ以外でどこまで表現出来るようになるのか気になる

ので、仕事が終わったので今から試そう >>783

30枚も素材が集まらないんや!(マイオナ) 今思ったけど、他人から頂いたloraのデータで指定されてるキャプションとかタグとか、

閲覧できるツールとか無いんかな

>>784

そこは学習素材を増やすしかないと思うで

生首LoRAは試してないから何とも言えんわ

>>787

AdditionalNetworksでコメント埋め込めるようになったから製作者が情報埋め込んでくれるのを期待やな >>786

生首の要領で服装も行けんのかな

そんで生首LoRAと組み合わせて厳選すれば素材増やせそうやけど バッチサイズで出来が変わるとかレスを見たけど512のバッチ5と768のバッチ1どっちがええかな

マイナー民は少ない素材で学習→ガチャして、奇跡の一枚を集めてまた学習の繰り返しでクオリティ上げていける

>>788

やっぱキャラ再現精度高いのを目指すとなると

・均一で高品質、かつ多種多様な素材が必要

っていうのは、至って自然の流れよな

>>790

学習元のデータ品質が良いなら、純粋な画質面では後者の方が良さそうには思えるが、実際やってみんとわからんよね シチュエーション民もそうやな

アナルゼリーや前貼りはAI出力も混ぜながらクオリティ上げていった

アナルビーズや馬姦は生成クオリティがちょっと微妙でノイズになりそうやから混ぜ込むの躊躇してる

lora作るときblue eyesってタグが入ってたら目の情報は割合かなりblue eyesに吸収されるみたいやけど

それぞれ吸着しやすいタグとかあるんやろうかな

画風全部吸ってくれるタグとかあると便利なんやけど

閃いたわ

自分で描けば色んな素材用意できるやん!ワイ天才か?

2度閃くとは天才か

でも正直、ちょっと頑張って顔だけ時間かけてしっかり描いたら、それなりの成果は出そうに思える

ワイcolab民dreamboothのインストールに成功する

ということで次は画像集めや

100枚くらいあればいいですかね?

>>794

「illustrated by (意味が無に近い1トークンの何か)」

なんてキャプションに入れたら絵柄吸い取ってくれんかな

そして呼び出し時にはこれを入れずに絵柄を捨てる

まあこのぐらいで吸い取れたら苦労はせんかとは思うが後で試してみるわ Loraの画風学習ええな

思ったより低ステップで済むし、適用するモデルを気軽に選べる自由度がある

あとDBでやった時より画風出る気がするわ

キャラ再現Loraと合わせても画風出るかは相性次第やけど

>>798

>>767 でも書いてあるけど枚数より品質が大事だってさ

解像度の低いとか欠損があるとか問題のある画像は学習に使っても無駄になるぞ >>803

別にそれで問題ない

ただ左上のロード済みのモデル分だけメインメモリ食った状態で回す事になる

メモリ32GBでガン盛りとか予め空のモデルをロードするとか対策が必要 >>806

さんがつ!!!メモリなら48あるしいけるやろ! LoRAめっちゃ便利だし楽しいんだけど

最近脳みそがシコるよりもLoRAの完成度を上げる達成感を優先するようにバグってきた

生首にする前に適当に切り抜いてマルゼンスキームでキャプション付けて学習してみたけどこれでも結構着せ替え出来るんやな ただ正則化画像0枚なのもあってアニメのキャプ多く使うとがっつりアニメ塗りになるわ キャプションで何かのタグにアニメ塗り吸収させられたらええんやけどな

(学習時のパラメータ書いといた)

(学習時のパラメータ書いといた)

学習画像

1枚の画像から過学習させてお気に入りのモデルで出力+選別して学習素材を増やす手法よく取ってる

顔は結構やりやすいけど衣装が難易度高いのよね

ただやっぱりどうしても時間はかかるし、学習用と選別出力用のPC2台欲しくなる

マイナー推しワイ、学習用素材を増やすためにまずイラストの描き方と構図を学ぶことを決意

キャラ再現Loraの正則化画像を画風再現Loraを使ったモデルで生成したものにしたら上手い具合にマッチしたりとかせんかな

学習素材が少ないときの差分の作り方

例:帽子を被っていてボールを持った立ち絵しかない

元の画像から帽子だけ切り抜いた画像とボールだけ切り抜いた画像を作る

帽子を被った画像だけ red cap をタグ付け

ボールを持った画像だけ holding poke ball をタグ付け

画像生成の際、red capとholding poke ballで帽子とボールの着脱が可能になる LoRA学習すげぇわ

まだ学習素材に余力残してるからこれはもっと行けるで

うひひ

sd-scriptsは1エポックごとに中間画像を吐いてくれたら神なんやがな

学習中にlossしかわからんからうまく行ってるか判断しにくいわ

>>813

有名絵師のイラスト数百枚とキャラ画像同時に学習させてみたらかなり近いものはできたよ

ちょっと素材雑に用意したから使い物にはならんかったけど

>>817

そういえばui版ってなんか学習中にプレビューでなかったっけ? >>818

お~もろモ誰先生やん

つーかわざわざLora作らなくても正則化画像に再現したい画風の絵師さんのイラスト入れればそうなるのか >>814

この方法で体も分解したら素材1枚からポーズまでどうにかなりそうやね

マイナージャンルでも自分で描くよりは早そう

四白眼キャラって何気にむずいな

当然やけどマスピ顔から離れるほど打率下がるんで画像枚数の少ない学習と相性悪い >>815

トワセツ再現しようとしてたニキかな?

着せ替えいい感じやね >>825

せや!

最初から2人まとめて学習させようとしたのが上手くいかんくて、今一旦トワのみにして、タグ並べを工夫したりコマンドの細かい数値いじったりしとる

towa kimono, towa yukata, towa witch dress, towa hair flowerとかいくつかタグ付けたらそれっぽい区別ができてくれてニヤニヤやで 1111久しぶりに更新したら、xformersエラー吐いてないのに

速度が3分の1になってしまった・・・

やっぱり生成したいモデルで学習したほうがいいというわけではないんだな

特にこねくり回してマージ繰り返したようなモデルはイカン

その他が同じ条件でもNAI学習で後から好きなモデルにしたほうが明らかに出来がいい

顔の再現度はもちろん着せ替えさせた時の衣装クオリティも段違い

NAI学習

こねくり回したモデルで学習

>>814の応用

頭だけの画像セットと体だけの画像セットを用意し、

好きなキャラに別のキャラの衣装を着せる

>>831

これ丁寧コラマシーンやん

ポーズ変えれるんか? >>830

二臨のカード絵、マイルームで表情差分7種類くらいをスクショしてそれぞれ反転でかさまし&katanuki

あとは二次創作で完成度高いやつを足して合計30枚

二臨にしたのは二次創作や公式絵師の投稿イラストも二臨が多いから統一したほうが着せ替え用に服タグ分ける時多少は楽かなって

だけど二次創作絵は顔のクオリティ優先で一臨も少し混ざってる めっちゃどうでもいいけどポケマス勢がおってうれしい

>>832

体の学習画像のほとんどに同じポーズの上半身が映ってるので上半身のポーズを変えるのは至難の業

一方で下半身は映ってない画像が多いので自由度が高い

解説サイトとか見ると画像の名前は連番にしましょうみたいなこと書いてあるけど

適当でも平気よな??

>>176やけど、network_dimが128でもlearning_rateを減らしたらうまく学習されたわ

network_alphaを1にするときは1e-3がいいって書いてあるんやけど…… >>836

適当でも平気

連番にした方が管理しやすいってくらいかな >>836

イケる。でもエクスプローラーで全選択→F2→pokemon→Enter

とかするとpokemon (1), pokemon (2)とかなるで。始めて使ったわこんなん LoRAでの学習用の素材画像って、解像度高いほうが精度上がったりする?

Colabでloraやりたいんやがここから先に進められん

どうしたらええんや🥺

つよつよGPUじゃないとそもそもできんのか、スレ汚し質問スマン

生成 step の劇的な高速化が進んでるけど現在のモバイル端末程度のチップで秒間 30 枚くらい生成できるようになれば 1 枚 30 GB とかの Blu-ray じゃなくて数 GB のモデルで配布してリアルタイムに生成するとかそんな未来が来るのかな~

なんて思ったけど無さそうだな

>>783

おるで。むしろ基本絵1枚をTaggerに投げてそのまま学習にぶちこんで楽してキャラ再現させる低リソースの怠惰な学習が可能かテストしてる

AIで作ったキャラの同一性問題もこれでまぁまぁ解決するんじゃなかろうか

今のところの感触だと、低リソース&意識低めの学習だと「いまは水着を着てほしいのにジャケットを着るぞ→ネガティブにjacket:1.3や」みたいなプロンプトレベルで調整するいつものAIイラスト生成みたいになるかな(サンプル:勝利の女神NIKKEのアニスってキャラ※重要:寄り目が可愛い)

どうしてもまんこにモザイクと黒線入る問題このスレで見た画像の一部消す手法でまんこを透過させるとモザイク入らんようになった

誰か知らんがサンガツ

>>833

thx

参考にさせてもらうわ

なんか行ける気がしてきたんご >>847

解決したならええけどbar censorとかmosaic censorみたいなのNPに入れとけば消えんか? あ、すまんそういう学習しちゃうから根本的に改善したいって話か

>>782

このやり方でやったら確かに未編集に比べて特徴を覚えてくれてるわ

ただ128dimでやったら合わないモデルが出てきたから32でやるべきだったかも

civitaiのヤマトが原作よりすぎてたから自分で作った

画風学習の場合ステップ数はどれくらいがええんや

画像20枚、lr=1e-3、バッチサイズ1で1000ステップ(50epochs)が多いんか少ないんか感覚が全然分からん

>>842

ワイは4ちゃんのノートブックでやったら学習できたで

ちなそれはわからん 層別LoraのUnetってINとOUTの数合わないけど非対称なんか?

呼び出しトークンに目の色は紐づけない方がええな

催眠できなくなっちまった

キャラでは難しいけど画風なんかは逆に可能な限り大量でやるのもいいのかもしれない

約500枚、切り抜いたり低品質っぽいやつの排除とか一切してない状態でやったけど満足のいくものになった

(こんだけ枚数あれば多少ヘボが混ざってもそれを上回る量の良質が吸収してくれるので少量を丁寧に画像やタグを編集するよりむしろ楽)

手動のタグ編集もリストから自動除外したものだけ

4ちゃんノートロラする場合気を付けるところ書いてくわ

1 必要なハギングフェイスのアクセスtokenの種類はwriteやで(ハギングフェイスのセッティングからアクセスtokenのwriteつくれるからつくってやで)

2 数ヵ所あるパス入力のところにデフォでエニシングとかクオンとか入ってるがそこに自分の学習モデルや生成したロラのパスをコピーして上書きしてやで

モデルの名前だけコピペするところもあるからそこもよく見て気を付けてな

(ファイルブラウザ開いてファイルのうえで右クリパスコピーできるで)

3とりあえず動かしたいだけなら最初は細かいパラメーター?重みみたいなの?はいじらずデフォでええと思うで

4コラボだと画像50枚あたり30分かかるで

5一応今の4ちゃんロラノートはエラー出ずに動いとるで

要はアクセスtokenとパスとモデルネームの入力だけ気を付けてればええということやで

まあ、やってるうちに分かると思うで

そんな難しくないでこれ

>>859

これ666学習モデルで使えたらすごいシコ度高そう

明日試してみよう >>801

イナリワンとスズカ入ってたらそこだと思う 最近のLoRAはAdditional Networksタブから学習設定見れるの多いからからそこから設定拝借するのもええで

>>473

kohya氏のnoteにそれの使用方法があって

Colab使った例が載ってたわ

ビルド済みインストールだからコンパイル要らん

pipじゃなくてmimというのを使ってたわ 明らかにpromptにはいれてないLoraが読み込まれてるのこれwui側のバグだよなあ…

そういやみんな昨日あたり話題になってたモデルの破損の修復したんか?

そのまま使ってるんやけど

欠損画像を素材にしたらだめってどのくらいの欠損なんやろ

AB2人が重なってる立ち絵からA切り抜いた後の顔の一部ぎざぎさ削れBは駄目ってこと?

>>871

dynamic promptsだったら心当たりあるけどそれとは別に関係ないLoRA読み込まれてるんか? レッド一枚ニキに着想を得てSGRUIで絵柄とキャラの分離学習試してみたけど原理確認レベルじゃ微妙やな

特に絵柄に絵柄以外のバイアスがかかっとるからこれをキャプションでよくよくキャンセルしないとダメそうや

あと似非正則化画像が口開けたのばっかだったせいでパッカーンしとる

ワイはFSSニキのおかげでメカ娘量産しとるわ

学習よりガチャ引いとるほうが好きみたいや

はいclip skipがたまに1になってる現象に気づくまでに2時間掛かりました

>>852

最後のやつの塗りめちゃくちゃ好みなんだけどモデルとかプロンプトとかどうしてます? ワイもエロゲ学習モデル作ってるんやけど需要あるんかな

学習用画像60枚くらいで繰り返しを20、エポック数を2にしてるけど、繰り返し回数減らしてエポック数増やした方がいいんだろうか

ステップ数は変わらないなら同じかな。バッチとこれらの説明調べてもグラフと関数から勉強しないと理解できなくて辛いやね

斜め正面の画像しか学習してなくても

(from side:1.35), (profile:1.35), (looking away:1.35), (looking to the side:1.35)

みたいに横向き系のプロンプト突っ込みまくれば横顔になってくれるんやな

みんながloraやりだしてcivitai追いかけるの大変になった嬉しい話だけど

ガチャですこしずつ回転させていけば三面図とれるぐらい素材つくれるか

………それぐらいなら自分で描いたほうがええかもな

>>887

わかるで中々ケツから出てこんよな

その中でうまく半個体っぽくなるのはさらに低い

アナルゼリーニキのサンプルはSSRやわ

早くAIにマンコとアナルの違い識別して欲しい >>889

すげえ

これを学習させればどんどん角度増えるな

(メスガキ黒ツインテニキ…メスガキ黒ツインテニキ…flat breastsじゃなくてflat chestやで…) flat chestとsmall breastsの中間くらいが欲しいという苦肉の策説

LoRAの名前が違うのは気にしないでくれな

大量にバージョン作って管理してる残骸や

なんでそんなに透明度があるんや

そんなに素材あるジャンルなのか?

ガッフェの完成度にビビったわ どうやって学習させたんやろな

生成画像にちょくちょく出てくる左上謎ロゴくん

誰やねんお前ホンマに

4090でloraやってる人に聞きたいんだけど、素材10枚、繰り返し10回、epoch20、512で学習させた時ってどのくらい時間かかる?

ワイのとこだと20分くらいはかかるんやけど学習って画像生成に比べてGPU毎の速度の違いがガッツリ出る訳では無い?

>>887

これにしか見えんわ

リアル注意

video.twimg.com/ext_tw_video/1600184650365747202/pu/vid/640x360/0dUO0CUtUKEdqp1R.mp4

全く理屈が分からんけどいじってたら水晶玉をケツから産むようになってきたな…なんか芸術的

公開したおかげで面白いネタをゲットしたわ

ありがてぇやで flat chestはchestで家具呼び出すからtitsとかに置き換えたほうがええと思うで

>>901

謎ロゴはロリータ下着とか特徴ある服装出そうとすると結構出てくる

下着通販会社の画像で学習したんだろうな >>905

その謎玉クォリティ色んな無機物に欲しいわ >>889

そこまで綺麗に横向けるのか、ええ感じやん! 学習用画像zipにしてるけどグッグルドライブて開けて中身見られたりする?

>>912

実際一部の投資家からは「🤗はどうやって収益上げるつもりなんやAI投資やって言って金つぎ込んどる奴アホか」と言われとるからな

🎈🤗 >>908

ネガティブで消し去ろうにも上手くいかんしホンマ余計なもん学習しおって 作った画像をまた学習に回せばそのうち後ろも向けそう

本物とは違う髪型になったり違う服装になるかもしれんけど

>>897

おっいい感じに透明感でとるなぁ

ワイもまだまだ研究が必要やな 歯磨きフェラ

普段あげないタイプのイラスト渋に上げたら「お前の絵いい絵だな!うちでゲーム開発の手伝いせんか?」って外国の企業から連絡来たけどこういうのって無差別に送るんかね

詐欺とかじゃないとしても相手がAI絵なことわからんで送ってるんやから相当な無能やでそいつ

座学というか言葉で理解しないと動けないせいで今日生成も学習もできてへん

難しいんやな…

キャラクターを小さく配置して背景メインにしたいんやがなんて入力すればええやろ

>>902

書かれてる設定だと18枚に42分掛かったわ >>925

背景のプロンプトを強調して人物描写は弱めれば勝手に小さくなったり消えたりする X/Y plotで<lora:hogeA:1>切り替えってどう書けばええんや?<lora:hogeA:1>, <lora:hogeB:1>て書くと動くけどメタデータがなんかめためたになるんやがhogeAだけ並べると効かないみたいだし

学習したlora2つ

碌な生成結果の確認もせず次の学習を走らせてしまったのでとりあえずこれだけ

何の絵柄を学習させたかワカルカナー? >>931

普通にpromptsrにhogeA,hogeB入力で行けない? >>932

ワカルヨー。

具体的に書くのはやめておくけど。 >>919

ぐう抜ける

ガッフェLoRAになんか組み合わせたりしてるんやろか? >>926

18枚で42分ならまぁ10枚20分も妥当くらいか

サンガツ Hugging FaceのbasilmixとHassanBlend1.4のckptからトロイの木馬検出されてビビってる

Hassanの方はcivitai かもしれん

削除して他のものもsafetensorsに差し替えたけど1週間ぐらい使ってた

大丈夫やろか?

生首+下半身でちょっと自由度の増した同キャラ騎乗位lora

首すげ替えも可

技術が発達した結果雑コラ以下の画像を生産することに意味が生まれるの予想外やな

胴体描かないことでそこに自由度が生まれるの面白すぎるでしょ

Lora学習回してる間に過去の出力結果見返してたらちょい面白いのがあったので

https://imgur.com/a/uqMOLPd

適用するとなぜかやたらこういう構図を出してくる謎に学習失敗したloraがあってさ

学習元にもプロンプトにも分割要素無いんだぜコレ?

求めていたのとは全然違うんだけどこれはこれで面白いよな! 局所最適解の見える化ってやつなんかな

ワイも一度断面図出したくてたまらないのができたことあるやで

面白い上にかっこ良くてええな

>>940

まだまだもっと自由度を上げてもっと精巧に奇形を少なく幅を広くAIさん進化してくれーーーー!!!一生ついていきます!!! ローカルloraやろうとしてパワーシェルが使えないと言われてchatGPTに言われるまま昔苦戦して外したanaconda3入れてるわ何度手間だ

でも大丈夫今回はchatGPTがいるから何かあっても助けてくれるはず

2021年以降のことを全く知らないのと知らないことを知らないと言わず真顔で大嘘つくのには注意するんやで

>>947

そこだよな一応現在のwebの情報も入れれるツール付けたけど何処まで効くんだろう >>946

パワーシェルが使えないって、もしかしてとしあきwikiの通りにやってもエラーになるとか?

自分もあの手順通りにやってエラーなったけど、あとからパワーシェルに権限与える?人手間が必要だったってことを知った >>949

【保存版】Kohya版LoRAインストール&設定っていう記事見ながらやってる

もしかしていらなかったの? 違うホームページ通りマイクロソフトストアとパワーシェルのPowerShell-7.3.2-win-x64.msiをインストールしても

(新機能と改善のために最新の PowerShell をインストールしてください!https://aka.ms/PSWindows)って出るわどうしようchatGPTも教えてくれないw

何でこんな面倒臭いまま放置してるのw >>824

かわE 地味顔にエロい身体ええよな

三白眼すきやのに眉毛と融合したりアイライン二重になるから学習しんどいわ

顔アップにblue eyesタグ付き学習してプロンプトにも入れるようにしたら若干マシになった

目以外透過した画像で良くなるか試してみるやで 最新版じゃなくても使える要にして欲しいパワーシェルとかどうでもいいのよ

パワーシェルとやら入れたけど結局コマンドプロンプトで解決しました

>>952

Windows11ならpowershell関係はpowershell

winget install -e Microsoft.powershell

winget install -e Microsoft.WindowsTerminal

これだけが一番シンプル

以後はpowershellを起動するんじゃなくWindows Terminalを起動する(Windows Tetminalはpowershellやcmdを同じウィンドウの別タブで使えるソフト、素のpowershellやcmdを使うより操作性がずっと良くなる) あと多分PowerShellのバージョンは別に多少古いくらいならsdの動作には何も影響せんで

>>956

すみません、いけたっぽいです赤い文字は全部エラーだと思ったら違ったみたい管理者権限変更とか意味が分からなかった赤ちゃんDL公式が作って欲しいw >>956

読んでみたらこっちの方がいいのかなプログラミング全然分からない そういえばNAIとそのリークのVAE使うとき、高画質で画像だしたりすると、高確率でエラー吐き出すの未解決のままなんやが

VRAMは足りてるし--no-half-vae追加してもダメ

NAI系のやつだけ

原因わからん

1060 6GBでmedvram無しで1024x1536が地獄のように遅いなりに一応作れるのに3060 8GBで同じ条件だとメモリ不足でコケるのなんでだろう

colabのautomatic1111で質問や

wikiにある通りsd-webui-additional-networkをインストールして再起動したが一向に左下にadditional networkが出て来んねん

同じような症状のやつおるか?

>>539

Abyssでそれ作るの台無し感が凄えな 正則無しでキャラLoraとか作るとabyssの絵柄とか関係なく上書きするし今更やろ

>>964

loraは色々混ぜやすいから使い道があるかもしれない

例えば綺麗なセックス体位が出やすモデルに組み込んでみるとか xformersがインストールされていないようです

書かれてる通りにしたのにどうして!!!

ローカルでやってるんちゃうの?

webui.user.batを編集するだけやろ

>>969

何処参考にしたらええんやろ

1111氏のでできるの? そもそもxformersがインストールされてない、ってのは何を見て判断した?

言動を見た限りだと本当にインストールされてないのかを正しく判断出来ているのかが怪しい

>>971

ポップ式の打ち込みが終わったら出てきて学習が止まって出力が何もされてなかったんです >>972

ごめんねw名前が似てるのが多くなってしまって、前のdbとloraとかhnはなんとかできてたんだけどねw >>977

その記事の通りしたらポップアップに打ち込んで学習スタートから先がさっきのxformerがでて色々出た後に何かキーを押してくださいと出て止まっちゃってw ああ、ポップアップGUIってオプションの引数もそうやってポップアップに入れさせる感じなのか…

それ頼りでやってるとコケた時に直すの逆に難しそうだな

多分、run_popup.batをメモ帳とかで開いて

--xformers

って書かれてるところ探して消してみたらxformers無しでの起動が出来るんちゃうかな

最終的にはポップアップとか使わん方向で慣れるほうが楽やと思うけど

torchアプデしたらxformersのプロシージャがないとかで使えなくなってしまった

>>982

ちゃんと調べた訳じゃないんだけど

本来は違わなくて、どっちもプロンプトでしかない

fine tune用のjson作る時に、自由文もbooru tagも両方まとめてプロンプトに出来た方がいい感じに学習出来るはずだよね、ってことで

それぞれBLIP(caption)とdeepbooru(tags)とを順番にやってそれをくっつけたものをpromptとしてCLIPに渡してる程度の意味しかない

って感じで自分は認識してる >>979

webuiじゃないと分かりにくいわ

前のも対応してくれるまで放置してたw流行ってるから楽になったのかと思ったんだけどねw

>>981

乙 >>985

まあワイもモデルの階層マージとか未だに手出ししてへんわ

楽になったからというよりは出来上がるファイルサイズ抑えられるようになったのとHWスペックのハードルが下がったからって方が大きい気がするで そろそろ人が多いネトゲみたいに初心者質問隔離スレが要るんかもしれんな

webuiならddpnのやつあるじゃん

Vram喰うからおすすめはしないけど

sd-scriptもコマンド打つだけだから学習は全部こっちでやってるわ

DBですらsd-scriptつかってる

調べたらpython3.10じゃないとダメみたいでダウンロードしてたんだけどパワーシェルをDLする時にDLしたアナコンダ3がpyathon3.09でそっちに切り替えられてたせいなのかもしれないよく分からん

>>987

別に初心者居た所で邪魔とは全く思わん

>>988

sd-scriptsがTIも出来るようになったらしいからいつかやってみたいなと思ってるわ >>988

あれ操作の仕方が分からなくてw正規化画像何処に入れて何処をどう設定すればいいのか分からなくてw SD-scriptは更新早すぎて他の作者のGUI使ってると対応に数日待たないといけない事あるから結局CLI版使ってる

sd-scriptsのxformersは多分環境合わなくて導入できてない人もいると思うで

ワイがその1人

xformersなしで学習しとるわ

質問をするためのウォーミングアップをしても構いませんよ

>>883

これヤマトのloraやでー

7thV3Cにプロンプトはスクアットアナルだけなんやけど

このloraは128dimでやったら7thV3Cと学習素材の絵柄が似てるからか相性悪いのよな

条件真似したらできるかも ついさっき朝方にgrowthに変更しないまま今月もproの8ドル払っちゃったんだけど632枚の1024解像度を学習やらせ始めたら残り2時間半とか出て泣いてる

学習だけではvastでやらせられるように環境整えてようかなあ

むしろVRAM的には学習こそpaperspaceで生成とかやる方をvastか?

>>994

webuiは常駐でvram喰うよ

それ低減するために空の.ckpt読ませて動かしてるんでしょ

まあcolabならいいんでねって思ってるけど lud20230204083553ca

このスレへの固定リンク: http://5chb.net/r/liveuranus/1675113816/ヒント:5chスレのurlに http://xxxx.5chb.net/xxxx のようにbを入れるだけでここでスレ保存、閲覧できます。TOPへ TOPへ

全掲示板一覧 この掲示板へ 人気スレ |

Youtube 動画

>50

>100

>200

>300

>500

>1000枚

新着画像

↓「なんJNVA部★140 ->画像>260枚 」を見た人も見ています:

・なんJNVA部★68

・なんJNVA部★88

・なんJNVA部★99

・なんJNVA部★69

・なんJNVA部★87

・なんJNVA部★75

・なんJNVA部★84

・なんJNVA部★80

・なんJNVA部★76

・なんJNVA部★97

・なんJNVA部★92

・なんJNVA部★89

・なんJNVA部★63

・なんJNVA部★72

・なんJNVA部★67

・なんJNVA部★64

・なんJNVA部★83

・なんJNVA部★73

・なんJNVA部★81

・なんJNVA部★74

・なんJNVA部★94

・なんJNVA部★65

・なんJNVA部★90

・なんJNVA部★96

・なんJNVA部★78

・なんJNVA部★98

・なんJNVA部★71

・なんJNVA部★91

・なんJNVA部★66

・なんJnovelAI部

・なんJNVA部★93

・なんJNVA部★70

・なんJNVA部★86

・なんJNVA部★85

・なんJNVA部★79

・なんJNVA部★82

・なんJNVA部★77

・なんJNVA部★95

・なんJNVA部★100

・なんJNVA部★137

・なんJNVA部★400

・なんJNVA部★127

・なんJNVA部★102

・なんJNVA部★403

・なんJNVA部★125

・なんJNVA部★134

・なんJNVA部★192

・なんJNVA部★139

・なんJNVA部★111

・なんJNVA部★141

・なんJNVA部★135

・なんJNVA部★132

・なんJNVA部★119

・なんJNVA部★130

・なんJNVA部★117

・なんJNVA部★110

・なんJNVA部★131

・なんJNVA部★108

・なんJNVA部★124

・なんJNVA部★128

・なんJNVA部★104

・なんJNVA部★145

・なんJNVA部★393

・なんJNVA部★136

・なんJNVA部★107

・なんJNVA部★410

を覚えさせたいときにはtaggerでタグ付けすると

を覚えさせたいときにはtaggerでタグ付けすると  、

、

(学習時のパラメータ書いといた)

(学習時のパラメータ書いといた)